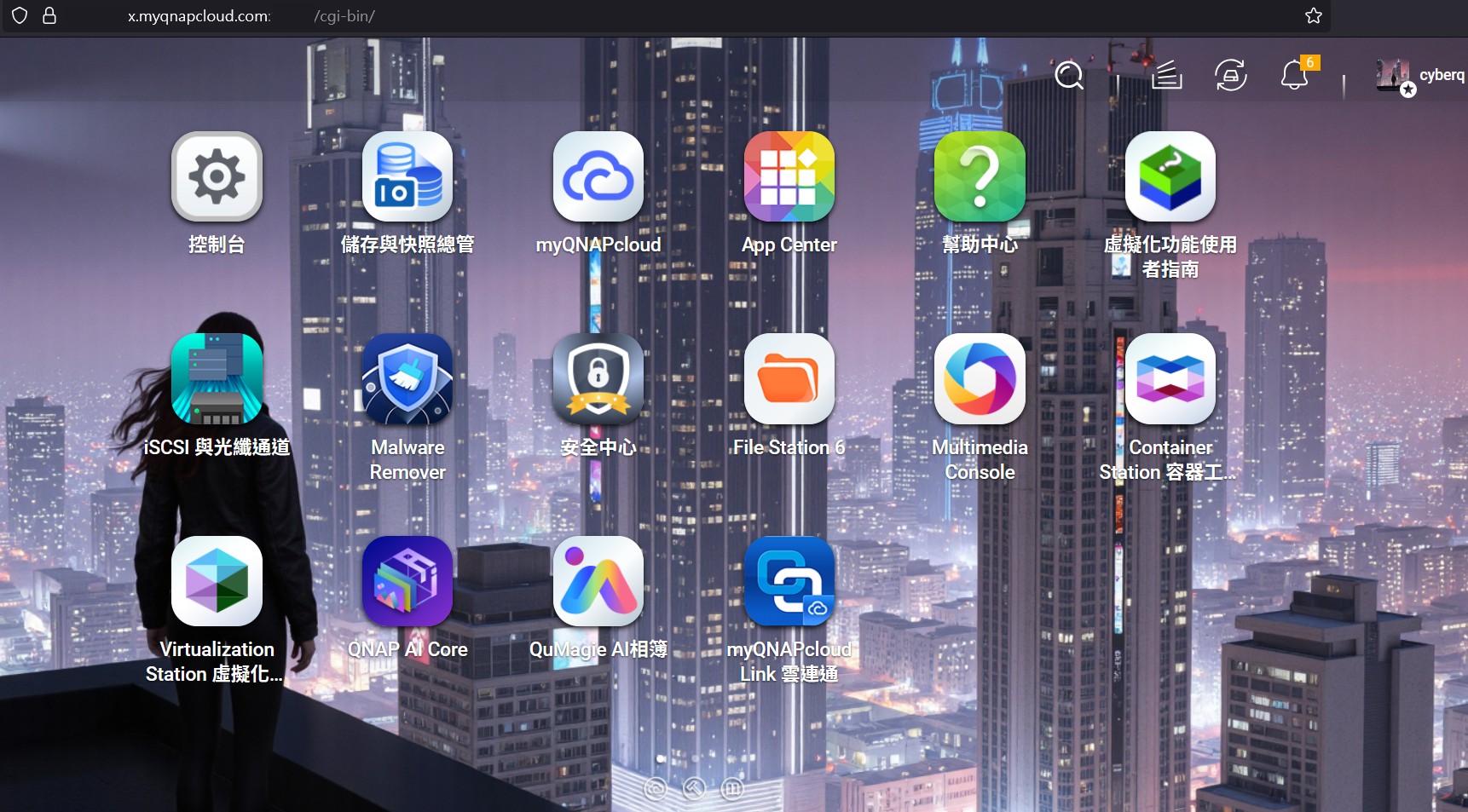

在 QNAP NAS 上使用 OLLAMA 運行 AI 模型教學

隨著人工智慧技術的發展,越來越多的應用程式需要 AI 模型的支援。QNAP NAS 不僅是強大的儲存裝置,其內建的容器功能(Container Station)也能讓我們輕鬆部署各種應用程式,包含時下熱門的多種 AI 模型服務。接下來我們將告訴你,如何在 QNAP NAS 上使用 Container Station 部署 OLLAMA,這是一個輕量級的 AI 模型執行環境,讓我們能在自己的 NAS 上體驗 AI 模型帶來的各種便利,以及最主要就是省錢以及避免部分敏感資料外洩,有些簡單的問題和日常的問題可以透過本地端 NAS 的 AI 模型來執行獲得結果,有需要更詳細的資料和更複雜的任務,再去企業購買的雲端 AI 大模型平台去完成。

OLLAMA 簡介

OLLAMA 是一個專為在個人裝置上運行大型語言模型 (LLMs) 而設計的開源工具。它提供了一個簡潔的介面,讓使用者可以輕鬆地下載、安裝和運行各種預訓練的 AI 模型,例如 Llama 2、Mistral 等。透過 OLLAMA,即使沒有強大的雲端算力,也能在本地環境中進行 AI 模型推理。

準備工作

在開始部署之前,請確保我們的 QNAP NAS 滿足以下條件:

型號支援: 我們的 QNAP NAS 必須支援 Container Station 功能。大多數較新的 Intel 或 AMD 處理器型號都支援。請參考 QNAP 官方網站確認我們的 NAS 型號是否支援。

系統版本: 確保我們的 QTS/QuTS hero 作業系統已更新到最新版本。

記憶體 (RAM): 建議至少 8GB RAM,若要運行較大的模型,建議 16GB 或以上。

儲存空間: 依據我們想下載的 AI 模型大小,需要預留足夠的儲存空間。

Container Station: 確保已在 App Center 中安裝並啟用了 Container Station。部署步驟

- 啟用 SSH 並登入

為了方便後續操作,建議先啟用 NAS 的 SSH 功能,必要操作結束後,大家要記得再將 SSH 功能關閉以策安全喔:

登入 QNAP NAS 的管理介面。

前往 控制台 > 網路 & 檔案服務 > Telnet/SSH。

勾選 允許 SSH 連線,並記下 SSH 埠號 (預設為 22)。

使用 SSH 用戶端工具,以 Windows 來說,最簡單的話用終端機這個工具即可,連接到我們的 NAS。輸入我們的 NAS IP 位址和使用者名稱密碼。- 建立 OLLAMA 容器

OLLAMA 可以透過手動指令建立容器。

開啟 Container Station: 登入 QNAP NAS 管理介面,開啟 Container Station。

建立應用程式: 點擊左側導覽列的 建立,然後選擇 建立應用程式。

配置應用程式:

應用程式名稱: 輸入一個名稱,例如 ollama。

影像檔名稱: 輸入 ollama/ollama。

指令: 留空。

環境變數:

點擊 新增,輸入 OLLAMA_HOST,值設定為 0.0.0.0。

點擊 新增,輸入 OLLAMA_ORIGINS,值設定為 * (允許所有來源連線,若有安全疑慮可限制特定 IP)。

網路:

網路模式: 選擇 Bridge (橋接模式)。

連接埠轉送: 點擊 新增。

宿主機埠號: 輸入 11434 (這是 OLLAMA 預設的 API 埠號)。

容器埠號: 輸入 11434。

通訊協定: 選擇 TCP。

共用資料夾: 為了永久化模型資料 (以免容器移除後,我們跑過的AI資料就不見),建議掛載一個共用資料夾。

點擊 新增。

宿主機路徑: 選擇或建立一個資料夾,例如 /share/Container/ollama_data。

掛載點: 輸入 /root/.ollama (這是 OLLAMA 儲存模型和資料的預設路徑)。

資源限制 (選填): 我們可以根據 NAS 的硬體資源,設定 CPU 和記憶體的限制,以避免 OLLAMA 佔用過多資源。

建立應用程式: 檢查所有設定無誤後,點擊 建立。Container Station 將會從 Docker Hub 下載 OLLAMA 影像並啟動容器。我們可以在 應用程式 頁面看到 ollama 容器的狀態。

- 下載並執行 AI 模型

OLLAMA 容器啟動後,我們可以透過 SSH 或容器日誌來操作 OLLAMA。

進入 OLLAMA 容器的 Shell:

在 Container Station 中,點擊 ollama 容器,然後選擇 終端機。

我們將會進入 OLLAMA 容器的命令列介面。

下載 AI 模型:

使用 ollama pull 命令來下載我們想要的 AI 模型。例如,下載 llama2 模型:

Bash

ollama pull llama2

OLLAMA 也支援其他模型,我們可以在 OLLAMA 官方模型庫 查看可用的模型列表。

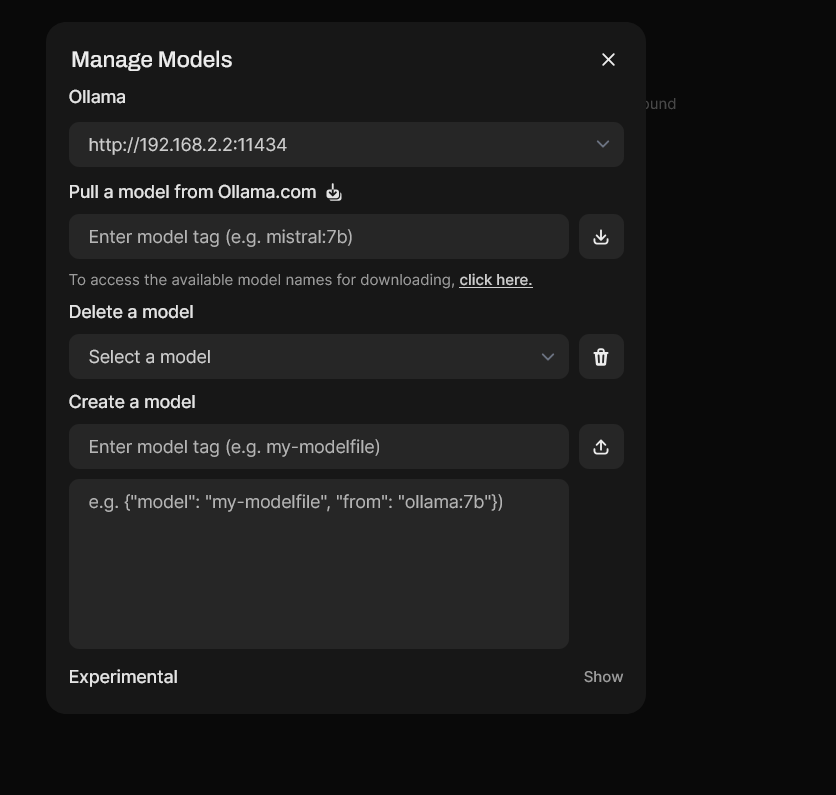

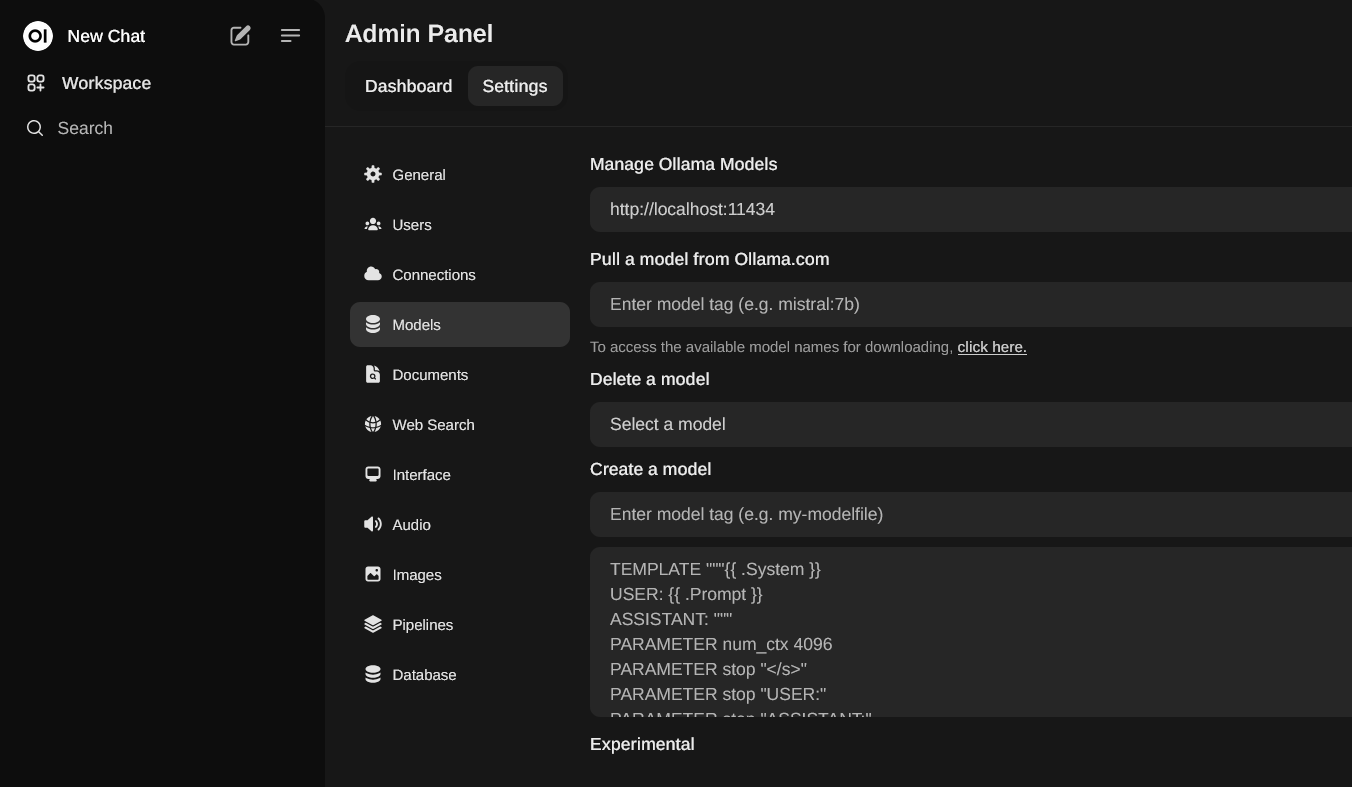

下載過程中會顯示進度。模型檔案通常較大,需要耐心等待。也可以另外安裝 webui 透過管理介面來下載 OLLAMA 支援的 AI 模型

運行 AI 模型:

模型下載完成後,我們可以使用 ollama run 命令來啟動模型並進行互動:

Bash

ollama run llama2

現在我們就可以在終端機中與 AI 模型進行對話了!輸入我們的問題,模型會給出回應。

要退出互動模式,請輸入 /bye 或按下 Ctrl + D。

- 透過 API 介面使用 OLLAMA

OLLAMA 不僅提供命令行介面,還提供了 RESTful API,方便其他應用程式或程式語言與之互動。

OLLAMA 的 API 預設監聽在 11434 埠號。我們可以透過我們的 NAS IP 位址和該埠號來訪問 API。

API 網址範例: http://我們的NAS_IP:11434/api/generate許多開發者可以使用 Python、JavaScript 等語言來呼叫 OLLAMA API,實現更多客製化的 AI 應用。例如,我們可以使用 curl 命令測試 API:

Bash

curl -X POST http://我們的NAS_IP:11434/api/generate -d ‘{

“model”: “llama2”,

“prompt”: “Why is the sky blue?”

}’

常見問題與疑難排解

模型下載失敗:

檢查 NAS 的網路連線是否正常。

確認儲存空間是否充足。

嘗試重新啟動 OLLAMA 容器。

OLLAMA 服務無法啟動:

檢查 Container Station 中的容器日誌,查找錯誤訊息。

確認埠號 11434 是否被其他應用程式佔用。

檢查共用資料夾的路徑設定是否正確。

模型執行緩慢:

AI 模型執行對硬體資源要求較高,尤其是記憶體和 CPU、GPU。

較大的模型會需要更多的記憶體和更強的 CPU 或 GPU。

考慮升級 NAS 的記憶體或使用更輕量級的模型。透過 QNAP NAS 的 Container Station 和 OLLAMA,我們現在可以輕鬆地在自己的本地網路中運行 AI 模型。

這在一般中小型公司和家裡滿重要的,最主要就是省錢以及避免敏感資料外洩,有些簡單的問題和日常的問題可以透過本地端 NAS 的 AI 模型來執行獲得結果,也能夠讓我們能更靈活地探索 AI 模型的各種應用。從智慧聊天機器人到文件摘要、產生圖片、影片,自動化處理,MCP Server 應用與 AI 代理等等,我們的 QNAP NAS 將成為一個不錯的 AI 實驗室和辦公空間的好用 AI 工作站。