Black Forest Labs 正式發布 FLUX.2 [Klein] 系列模型!CyberQ 透過 NVIDIA DGX SPARK 與 QNAP NAS 實測,用 ComfyUI 部署測試了 4B 開源商用版與 9B 非商用版,這款號稱 4 秒出圖的 AI 模型是否能成為 2026 年新熱門模型呢 ?

在中國千問 Qwen 圖像模型與 Z-Image Turbo 火熱一陣子、Stable Diffusion 逐漸顯露疲態、Midjourney 仍堅持封閉生態的當下,德國 Black Forest Labs (BFL) 再次引起市場和社群關注,繼先前他們的 FLUX.1 橫掃開源社群後,BFL 正式釋出了代號為 [Klein] 的 FLUX.2 Klein 系列模型。klein 這個字呢,在德文中是小的意思,可以被拿來形容尺寸或是輕微的事物,和本模型的訴求有搭上線,這個字與 德文的 groß (大的) 是相對的。

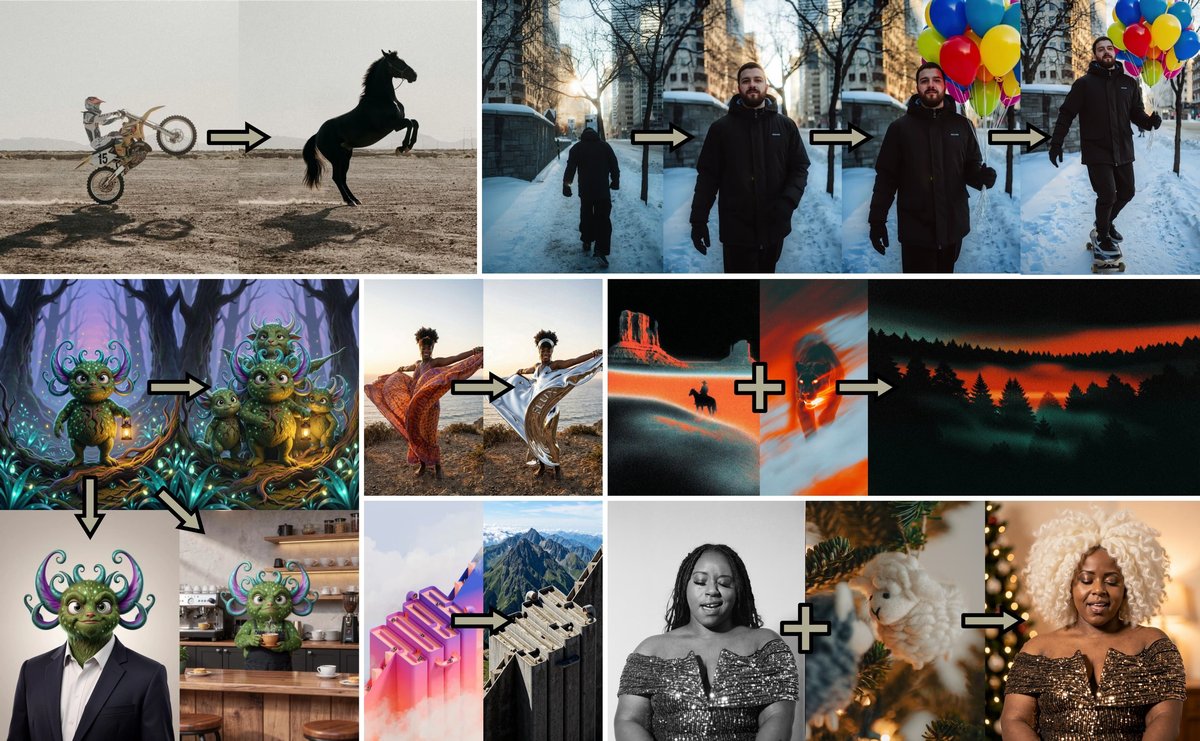

(Photo Credit : Black Forest Labs)

BFL這次的成果中,有較小參數,號稱超快速 AI 生圖的蒸餾模型,還能用在視訊記憶體 VRAM 較小的消費性顯示卡上,更是 BFL 與 NVIDIA 深度合作的成果展示。從針對 Blackwell 架構最佳化的 NVFP4 量化,到專為微調設計的 Base 版本,可利用 Base 版本進行 LoRA 微調,FLUX.2 [klein] 帶給市場的是高品質生圖與工業級部署,現在兩者均能可以兼得。

(Photo Credit : Black Forest Labs)

CyberQ 認為,FLUX.2 [klein] 不只快,更是第一個把「文字生圖+單/多張參考圖編輯」統一在同一個小型架構裡的模型,能處理風格轉換、語義編輯、物體替換/移除、多參考合成、迭代式編輯,且 4B 版本已全面開源 Apache 2.0,可合法商用,這對中小工作室與個人開發者意義重大。

新版的 FLUX.2 的 Text Encoder 文字處理編碼模型因為有使用到開源的 Qwen 4b/8b ,所以支援全中文的提詞 Prompt 輸入。

蒸餾版本可在約 1 秒內完成端到端推理,並在單圖與多圖參考編輯中保持一定的畫質,這是官方宣傳在 4B 版本中使用的成績,其中,Base(未蒸餾)適合最大靈活性與微調,蒸餾版本 Distilled(4 步)用於速度優先的部署。在蒸餾版的效能約 ~1.2s(5090),吃掉約 8.4GB 視訊記憶體。Base 版則約 ~17s(5090),吃掉 9.2GB 視訊記憶體。

核心規格為下一代硬體而生

FLUX.2 [klein] 在架構上延續了 FLUX.1 的混合多模態擴散變壓器(MM-DiT)優勢,但在效率與精度上進行了許多最佳化,並提供 NVIDIA FP4(四位元浮點數) 的原生支援。

根據實測,NVFP4 版 klein 9B 在RTX 5090/5060 Ti 上,4秒內就能出圖(甚至3–4秒)。4B distilled 在RTX 4070/3090 等中高階卡上,已可穩定 sub-second~1.x秒,以 CyberQ 的機器測試大約 7 秒可完成出圖,BFL 這次的更新,讓消費顯示卡真正能進入「互動級」即時迭代(interactive visual intelligence),可說是 BFL 這次主打的賣點。

FLUX.2 klein 關鍵版本差異

BFL 這次的釋出策略非常針對「生產管線」的不同環節:

大小區分:

4B → 大多數消費卡可跑(~8–13GB VRAM),4B版本全面Apache 2.0(可商用)

9B → 需要更高階卡(~25–29GB VRAM,如RTX 4090/5090以上),使用FLUX Non-Commercial License(非商業)

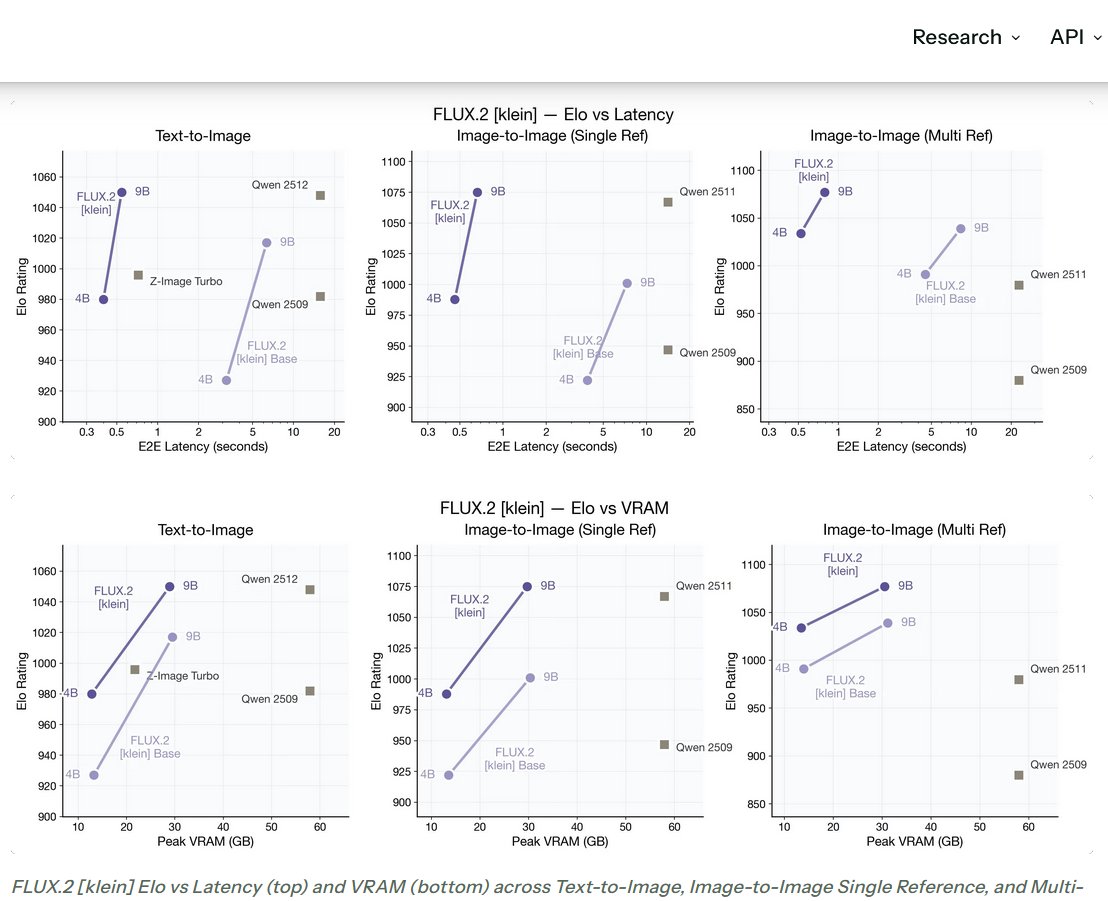

Figure Credit: Black Forest Labs

BFL 官方強調 klein系列是目前最快、性價比最高的模型,在品質 / 速度 / VRAM 三個方面都同時打敗 Qwen 與 Z-Image,而且原生支援多參考圖編輯(single & multi-reference),這是最被市場看重的功能。

FLUX.2-klein (標準版):在搭配 NVIDIA TensorRT 與最新的 Blackwell GPU (如 DGX Spark) 時,能實現低延遲的高解析度生圖。

FLUX.2-klein distilled(蒸餾版):這是經過蒸餾(Distillation)的模型,具備極致的推論速度。追求極致速度,通常是4步驟以內就能出圖,sub-second ~ 幾秒(視硬體)

FLUX.2-klein-base (基礎版):這不是用來直接生圖的最佳版本,而是專為 LoRA 訓練與微調 (Fine-Tuning) 打造的原始權重版本。輸出多樣性更高、梯度更完整,特別適合LoRA微調與研究,但速度比蒸餾版慢一些。對於想要訓練特定畫風或角色的創作者來說,這是唯一的起點。

NVFP4 版本:這是 BFL 與 NVIDIA 合作的結晶。透過模型量化技術,將模型壓縮至 FP4 精度,大幅降低記憶體頻寬需求,直接解鎖了邊緣運算與高併發伺服器的可能性。

CyberQ 指出,理論上如果你手握 H100 或最新的 Blackwell B200 晶片,NVFP4 版本會是相當快的生圖選項。

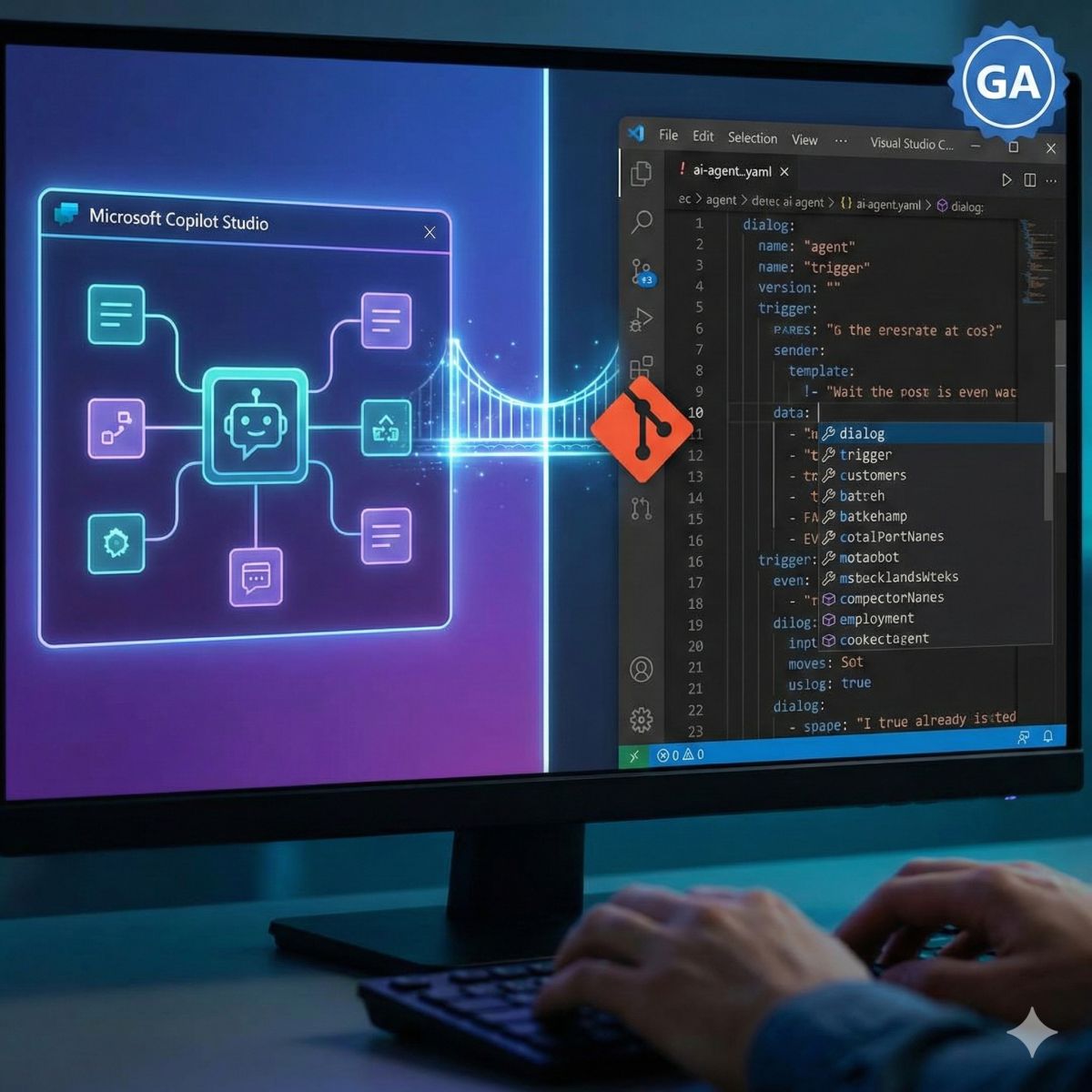

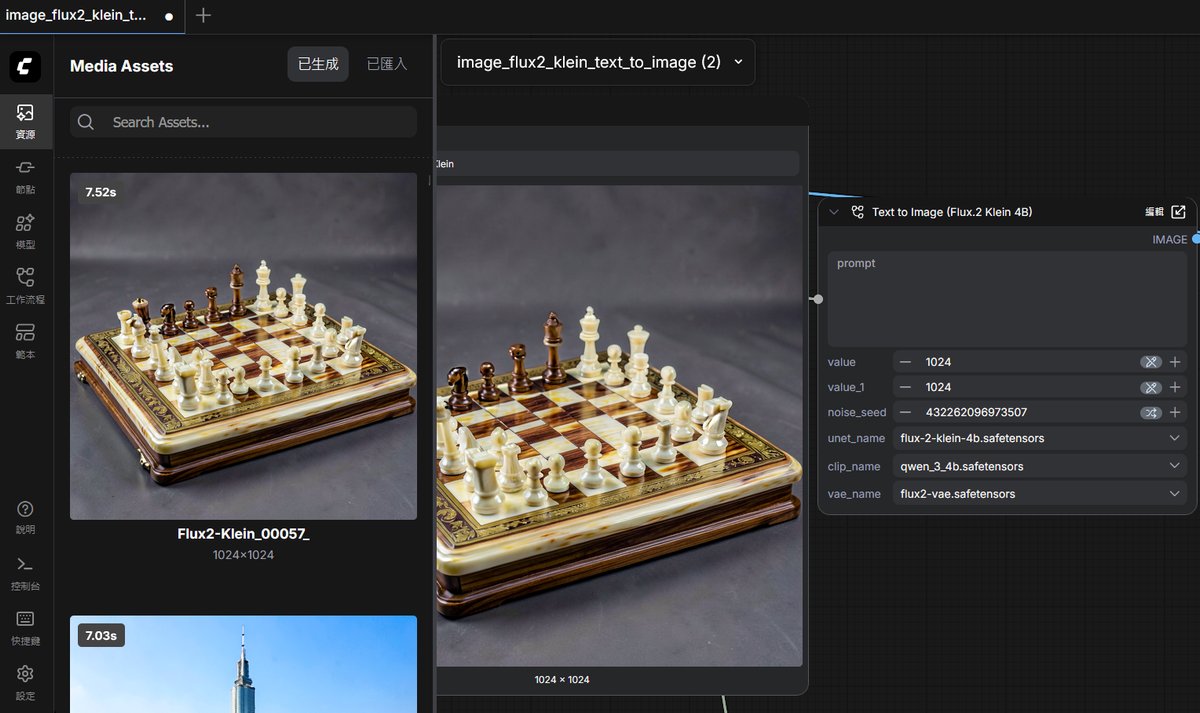

CyberQ 實測 FLUX.2 klein

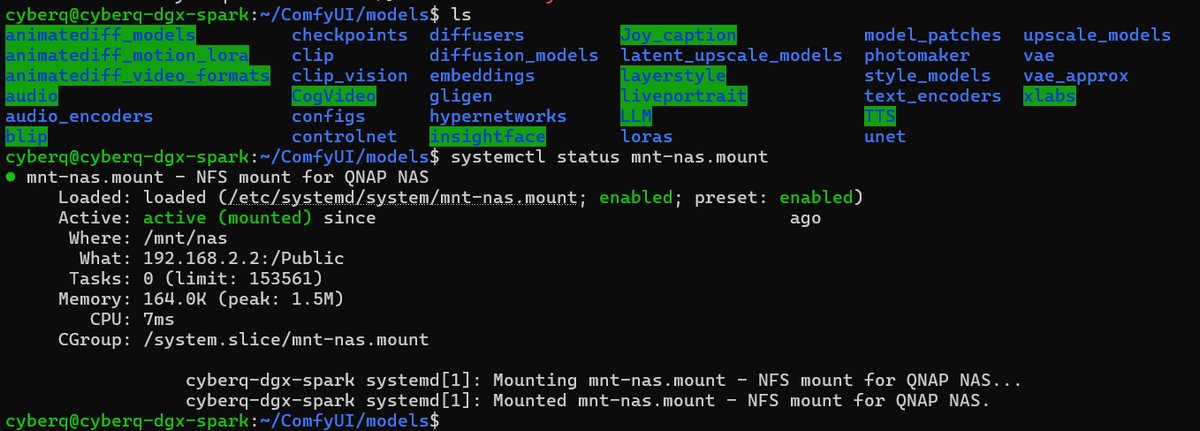

CyberQ 在 NVIDIA DGX Spark 128GB 上實測 FLUX.2 klein ,所有的模型檔案和輸出都掛載在 QNAP TS-855X NAS 上的 NFS 磁區,這台 QNAP NAS 上也實裝了 NVIDIA RTX A2000 12GB 顯示卡,並在 NAS 中的容器服務 Container Station 中部署了 ComfyUI,執行這款社群最熱門的新模型,採用的是 FLUX.2 klein 4B 版本。

另外,在桌機上也採用 NVIDIA RTX 5060 Ti 16GB 來執行,和 NAS 與 NVIDIA DGX Spark 都使用同一個 NFS 磁區來掛載,在 Windows 中則是以 SMB 的方式載入。這樣只要維護一份模型檔案資料夾,而輸出都能夠依據 ComfyUI 圖片輸出的自訂前綴字元來分類,如 RTX5060_klein_01、QNAP_klein_01、DGX_klein_01 等這樣的分類,整體還算是滿方便的,不同 NVIDIA 算力節點掛載同一個資料夾來做管理,日後增加 AMD 新的 AI 算力節點也能夠如法炮製。

跑了幾輪下來,測試的文字生圖片、圖片編輯,以及 9B、4B 等不同參數的版本,在高品質多步數的情況下,也是三十秒左右就能出圖,若採用 4step 的快速生成方式,確實幾秒鐘可完成出圖,如下圖,這張只有 4 秒就完成生成。

記憶體的部分則吃掉不少,在 CyberQ 的 NVIDIA DGX Spark 機器上,因為記憶體夠大,並不會吃滿,但也會吃到三十幾GB 的記憶體容量,測試 9B base 基礎模型跑 FLUX.2 klein 的 LoRA 訓練是夠用的。

但是消費性顯示卡呢,對 12GB VRAM 以下用戶來說,跑完整版 9B 模型仍顯吃力,只能跑 4B 模型,16GB 顯卡也有這樣的情形,可能會需要採用 GGUF 量化版本,才比較能在 16GB RAM 卡上穩定執行。目前,klein 4B distilled 在良好設定下已可壓到約8GB VRAM,搭配 FP8 或 NVFP4 後,9B 也能大幅省記憶體(約60%節省),這是因為 RTX 50 系列顯示晶片,對 NVFP4 有原生硬體加速,40 系列 GPU 跑 NVFP4 反而可能沒那麼快。

如果你有 RTX 4090 / RTX 5090 ,跑這個就絕對不是問題。

細節與光影的躍進

CyberQ 指出,這次的測試中可發現,在毛孔級細節的部分有很好的進步,[klein] 在處理皮膚紋理、布料材質以及複雜光影(如焦外成像 Bokeh)時,比 FLUX.1 更加自然,減少了 AI 常見的「塑膠感」或過度平滑的問題。

另外,文字渲染能力依舊強悍,這畢竟是 FLUX 系列模型引以為傲的文字生成能力,這次在 [klein] 中,不但得到了保留甚至強化。在生成招牌、海報文字時,拼寫錯誤率也大幅極低。

人體解剖學修正也有的改善,人體的手指與四肢的錯誤率進一步降低,雖然仍非 100% 完美,但「抽卡」成功率有顯著提升。

風格方面我們覺得有點稍微「太過寫實」,和中國千問的模型相比,[klein] 的 Base 模型過於偏向攝影寫實主義(Photorealism),在生成插畫或動漫風格時,需要更強的 Prompt 引導或採用特定的 LoRA 介入,否則容易看起來像照片濾鏡。目前在社群中,許多人用 klein-base 快速訓出優秀的動漫/插畫LoRA(因為base版捕捉特徵更完整),而4B base訓練出來的 LoRA,轉蒸餾或NVFP4部署後,速度與品質平衡較以往有改善。

開發者視角聚焦訓練 LoRA 的新標準

CyberQ 認為對於許多這樣關注 AI 模型訓練的技術人員來說,FLUX.2-klein-base 的釋出是很具備意義的。知名 AI 訓練工具開發者 Ostris 指出,使用 Base 模型進行 LoRA 訓練,能比使用蒸餾版更有效地捕捉特徵,且梯度下降的過程更為穩定。這意味著企業或工作室在訓練專屬 IP 模型時,能以更少的步數達到更好的效果。

CyberQ 實測建議使用 9B base 來做訓練,如果你計畫在 DGX 等高階算力平台或租用雲端 GPU 來進行訓練,請務必鎖定 base 版本,並搭配 AI Toolkit 或 Kohya_ss 等支援 FLUX 架構的工具,也可以使用 ComfiUI 的訓練 workflow。訓練完成後,再轉為 FP4 格式進行推論部署,這將是目前最高效的 AI 工作流(Workflow)。

開源 AI 的新里程碑

CyberQ 認為,FLUX.2 [Klein] 的出現,證明了開源模型在畫質上已完全不輸(甚至在細節控制上超越)閉源的 Midjourney v6。更重要的是,它與 NVIDIA 硬體生態的深度整合和綁定,為企業級的 AI 圖像生成提供了一條不錯的路線,我們可以用 Base 版訓練私有數據,用 NVFP4 版在 Blackwell 架構GPU 與相關機器上,能用更好的速度來推論生成圖象。

「FLUX.2 [klein] 很可能成為2026年開源生圖消費級互動工作流的新標準之一,對於身處內容創作、遊戲開發或廣告行銷的用戶來說,現在正是測試 FLUX.2 ,並評估是否將其導入工作流程的好時機。

相關連結

線上實測 FLUX.2 klein 9B 生圖 (HF 網頁)

線上實測 FLUX.2 klein 4B 生圖 (HF 網頁)

首圖由 Nano Banana AI 生成