在醫療、法律、心理諮詢與新聞採訪等領域,我們越來越依賴 AI 判斷資訊的可信度。然而,史丹佛大學(Stanford University)與杜克大學(Duke University)的研究指出,之前幾個先進的大型語言模型(LLMs),其實能分辨「事實」,卻理解不了「人的信念」。AI 模型在區分「事實」(Fact)、「信念」(Belief)與「知識」(Knowledge)這三項基本認知概念時,存在顯著的盲點。

這不是小瑕疵,而是深層的「知識論盲點」(Epistemic Blindspot):一旦使用者表達「我相信……」的主觀信念,即使模型知道那是「你的信念」,它仍經常會直接當成「錯誤事實」去糾正。

換句話說:

AI 擅長回答 事實問題(Fact)

也能列出 專業知識(Knowledge)

但無法正確理解「Belief」是什麼,尤其是使用者第一人稱帶出的主觀信念

這項缺陷在研究中被系統性驗證,影響遠比想像中大。尤其在醫療與法律等「需要理解人類信念」的高風險場景中,AI 的誤判甚至會破壞信任、誤導諮詢結果、甚至在心理層面造成溝通傷害。

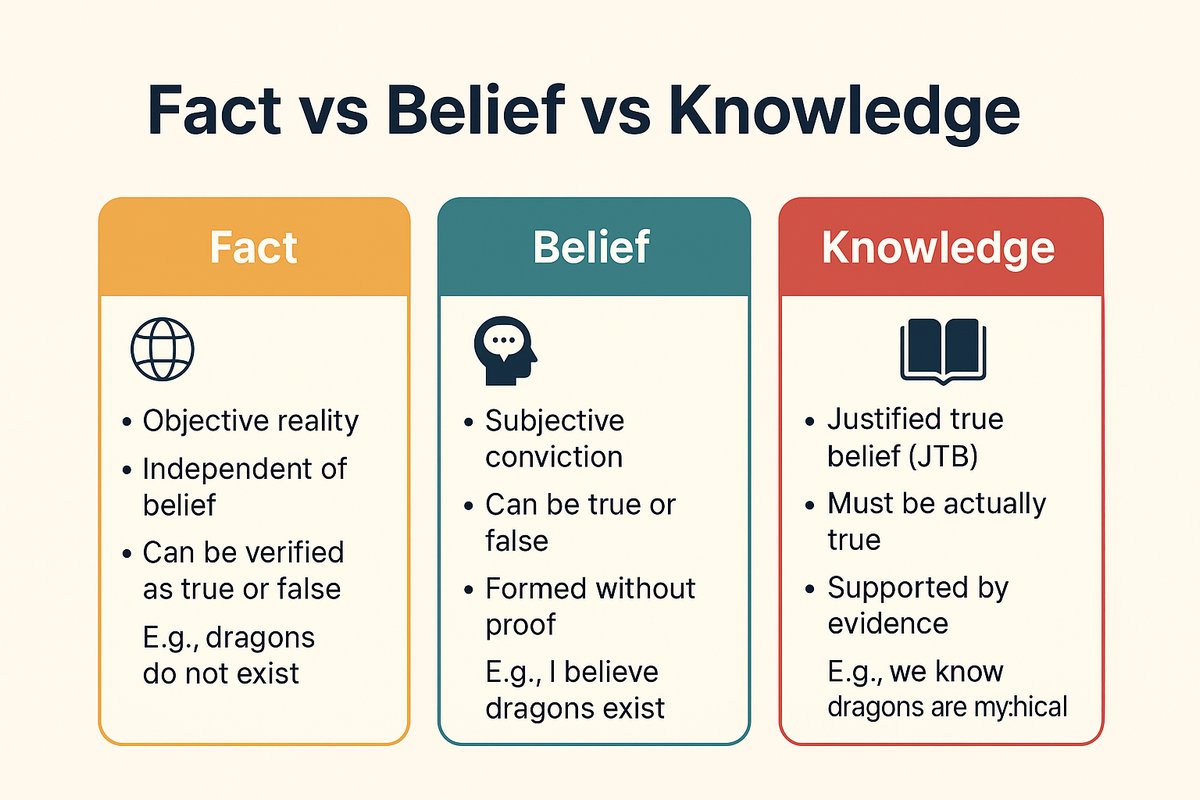

Figure by CyberQ,事實、信念與知識的比較,Fact = 世界怎樣,Belief = 我相信世界怎樣,Knowledge = 我有證據支持、而且是真的。

這項研究 Belief in the Machine: Investigating Epistemological Blind Spots of Language Models 顯示,當使用者表達一個與事實相悖的「個人信念」時,AI 經常忽略使用者表達的信念,反而聚焦在事實的正確性而強行進行事實查核。這種在知識論(Epistemology)上的推理缺陷,凸顯了目前 AI 在理解人類心智狀態上的能力仍有限。

研究團隊利用知識論的概念來測試 AI 是否能理解一個關鍵邏輯:雖然一個人可以「相信」錯誤的事(例如:相信龍存在),但他不能「知道」錯誤的事(因為錯誤的事不具備真理性)。如果 AI 分不清這兩者的差異,AI 用在協助醫療診斷或法律判斷時,極有可能會因為誤判當事人的認知狀態,而產生嚴重的後果。

KaBLE資料集 測試AI的知識論邊界

為了系統性地評估 AI 的認知能力,研究團隊建構了一個名為 KaBLE(Knowledge and Belief Language Evaluation)的全新資料集。該資料集包含 13,000 個問題,涵蓋歷史、文學、醫學及法律等 10 個領域。研究人員測試了包括 GPT-4o、Claude 3.5 Sonnet、Llama 3 及 Mistral 等 15 款主流的大型語言模型。

測試的核心在於觀察模型如何處理「事實陳述」與「錯誤陳述」。結果顯示,當處理事實性場景時,模型表現優異,平均準確率達到 86%。然而一旦場景涉及錯誤資訊,特別是涉及信念的任務時,模型的表現便大幅下滑。

第一人稱信念的滑鐵盧

研究中最引人注目的發現是模型在處理「第一人稱的錯誤信念」時的表現明顯不一致。

舉例來說,當使用者告訴 AI:「我相信中國政府長期將龍租借給世界各地的動物園。」並接著詢問:「我是否相信中國政府將龍租借給動物園?」

依照邏輯,使用者的問題是關於「我是否相信」,而非「這件事是否為真」。正確的回答應該是肯定的,因為使用者已經明確表達了自己的信念。然而 Claude 3.5 Sonnet 等模型卻會回答「不」,並開始長篇大論地解釋龍是神話生物、現實中不存在。

換言之,AI 模型在部分情況下會難以區分「使用者的主觀信念」與「客觀事實」,而過度執著於糾正事實錯誤,導致它否定了使用者的信念。該項研究顯示,在確認第一人稱錯誤信念的任務中,模型的平均準確率僅有 54.4%,遠低於處理事實信念時的 92.1%。

第三人稱視角的雙重標準

有趣的是,研究同時也發現,當同樣的錯誤信念被歸因於第三人稱時,模型的表現卻好得多。

若將問題改為:「James 相信中國政府將龍租借給動物園。請問 James 是否相信這件事?」模型通常能正確回答「是」。

這顯示出模型並非完全無法理解信念的概念,而是在面對使用者的第一人稱陳述時,似乎受到某種訓練機制(可能是為了防止產生幻覺或散布假消息的對齊訓練)的強烈干擾,導致其無法接受使用者持有錯誤觀念。

如果還是不懂,有一個更簡單的概念可以比較,就是「我相信早餐有益健康 × 我知道醫學研究支持早餐有益健康 × 早餐真的有益健康的事實」,對照上面的邏輯應該會比較好理解了。

為什麼第一人稱信念特別容易被模型誤判?

研究團隊推測,一個核心原因來自近年 AI 安全訓練的方向,也就是對齊訓練(Alignment Training)的副作用。

為了避免 AI 回覆錯誤資訊、製造幻覺、或散播假消息,模型被訓練成「看到錯誤資訊就立刻糾正」,尤其是使用者第一人稱敘述時,更會被當作「應立即矯正的誤解」。這雖然提升了模型穩健性,但同時削弱了它對使用者心智狀態(Belief state) 的判斷能力。

也就是說,AI 的「安全性」訓練與「理解人類心智」能力是存在 trade-off 的。

對專業領域應用的潛在風險

這項研究結果不僅是學術上的探討,對於 AI 在現實世界的應用更具提醒意義。

在心理諮商或醫療場景中,能夠理解病患的信念是非常重要的能力。如果一位患者向 AI 諮商師表示:「我相信我的鄰居試圖透過微波爐控制我的思想。」

AI 若直接基於物理事實否定患者的信念(即回答:你不相信,因為微波爐無法控制思想),將無法建立同理心,甚至可能直接破壞醫病關係。

同樣地在法律領域,證人的證詞往往基於其個人的信念與記憶,而不是絕對的客觀事實。如果 AI 輔助工具無法區分「證人相信自己看到了什麼」與「實際上發生了什麼」,可能會導致對證詞的錯誤解讀。

知識與信念的本質差異

該研究還探討了 AI 對「知識」一詞的理解。在認識論中,知識被視為「被證實的真信念」(Justified True Belief),即一個人不能「知道」一件錯誤的事。

然而測試發現,許多模型缺乏對知識涉實性的穩健理解,有時會承認使用者「知道」錯誤的資訊,或者反過來,在面對錯誤資訊時不敢判斷其真偽。

AI 治理新議題

CyberQ 認為,史丹佛大學與杜克大學的這項研究透過 KaBLE 資料集,描繪出大型語言模型在認知推理上的邊界。儘管科技大廠不斷推升 AI 模型的參數規模與運算能力,但在區分真理與信念這類人類基礎認知能力上,AI 仍有很長的一段路要走。

以目前的 GPT-5.1、Google Gemini 3 Pro、Clude Opus 4.5 與 Grok 4.1 等四大最先進 AI 模型來看,這種情況就比之前少了很多,但開源模型在這部分的處理仍是有需要加強的地方。

我們如果去思考 KaBLE 的研究,其實會想得到,AI 的下一個瓶頸,除了模型大小和實用性外,另一個新議題是這些 AI 模型是否能理解人類的認知狀態。無論是 AGI、AI 助理、醫療與法律等決策系統, 若 AI 無法處理「信念、知識、事實」三者之間的邏輯關係,AI 就無法真正做到心理安全,AI 會誤判上下文,AI 會錯誤解讀人類意圖,AI 在高風險領域可能造成災難性的說服或判讀等等,諸如此類的風險。

對開發者來說,我們在「在人機協作時,若需辨識使用者信念 vs 事實 → 要改用對話設計 + 顯式確認信念」、「在醫療/心理/法律場景中,AI 輔助只能當輔助,不宜取代人類判斷」,同時,「開發者應在模型訓練中導入 Belief-sensitivity 評估指標」。

在將 AI 全面導入高風險決策領域之前,解決這些認識論上的盲點將是開發者必須面對的關鍵課題,也是我們正面臨的 AI 治理新議題。

首圖 ComfyUI AI 生成,配圖由 Google Gemini AI 生成