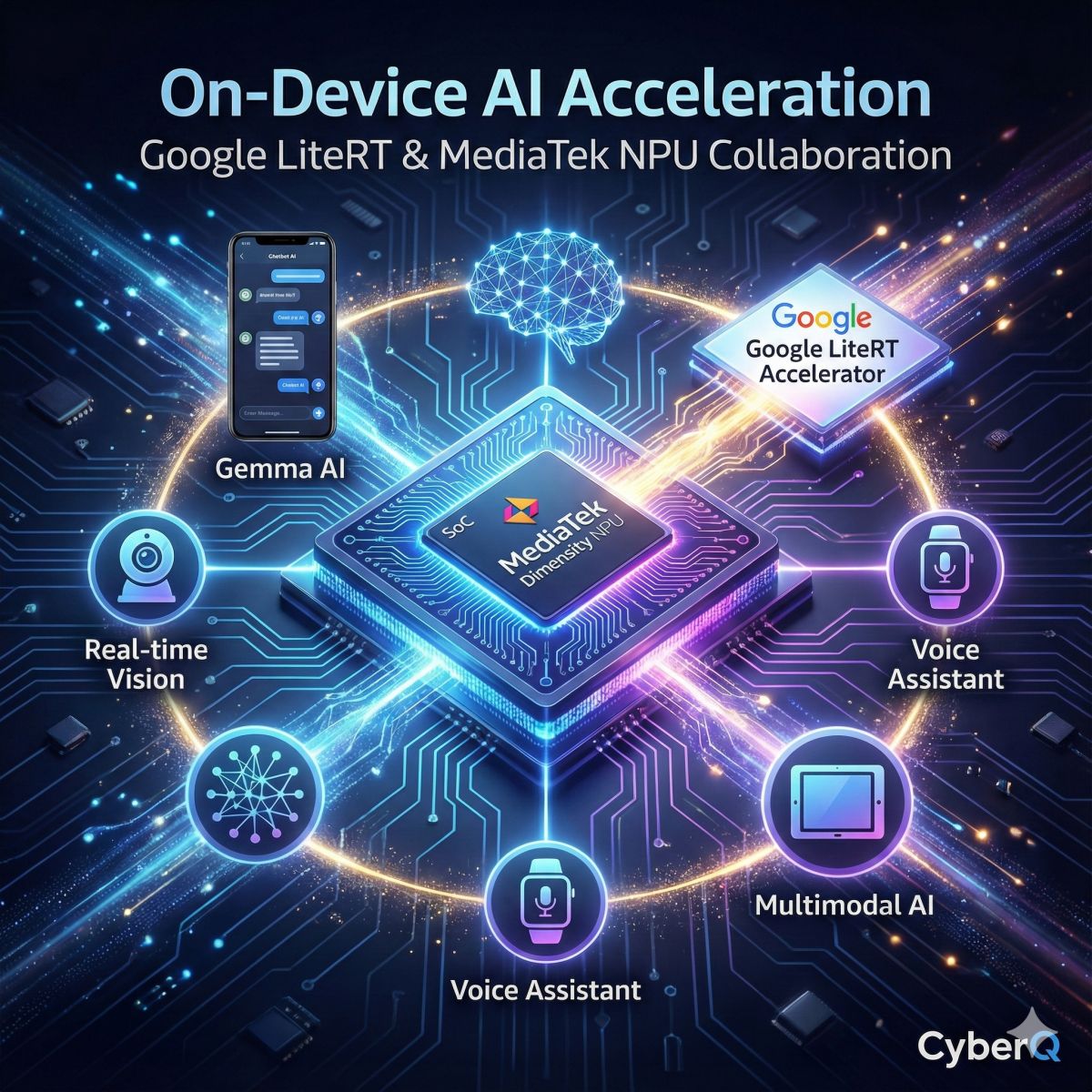

隨著 AI 不再完全仰賴雲端,而逐漸改在裝置端直接運算,許多 NPU(神經處理單元) 已成為驅動下一代裝置端AI應用的關鍵核心。NPU 高效能與低功耗的特性,讓過往難以在邊緣裝置執行的AI模型也得以順暢運作,然而過去因Android裝置的硬體規格和軟體版本過於繁雜多樣,導致開發者難以讓需要高效能運算的AI模型在所有裝置上都能順利運作。

近日 Google 在開發者部落格上宣布與聯發科(MediaTek)展開深度的技術合作,推出了全新的 LiteRT NeuroPilot Accelerator。這是一套讓開發者更容易把 AI 模型部署到 MediaTek 的 NPU(神經處理單元)上的工具,這項技術解決開發者在不同硬體環境下面臨的碎片化挑戰,讓開發者能夠透過統一的開發流程與最佳化工具,提升終端裝置用的小型 AI 模型在聯發科晶片上的執行效率。

LiteRT NeuroPilot Accelerator 可說是 TensorFlow Lite NeuroPilot delegate 的繼任者,部署體驗更佳。

開發者面臨的跨平台挑戰與解決方案

過去開發者若要在NPU上部署AI模型,往往面臨極高的技術門檻。由於市場上存在數百種不同的系統單晶片(SoC)組合,每種硬體都有獨特的編譯需求與SDK,導致開發流程複雜且難以維護。更令人頭痛的是,為了追求極致效能,必須為每一款晶片量身打造專屬的程式寫法,不能一套走天下。這對於希望應用程式能普及到大眾手中的開發者來說,是滿大的負擔。

LiteRT NeuroPilot Accelerator 透過統一的 API 介面改善了這些問題。開發者不再需要處理繁瑣的SDK細節,即可存取各種聯發科NPU的運算能力。

離線編譯與裝置端編譯的彈性選擇

為了滿足不同應用場景,LiteRT 提供了兩種彈性策略。針對目標明確的旗艦機種,開發者可採用離線編譯(Offline)模式,就像事先為特定硬體量身訂製最佳化,所有處理都已在前端完成,所以 App 啟動更快、資源占用更低。

而裝置端編譯(On-device),就像是通用款設計,App 在安裝到使用者的手機後,才會根據該裝置的實際規格自動進行適配。雖然首次開啟時需要一點時間進行調整,但最大的優勢是它能通吃市面上多款手機,減少了硬體碎片化的難題。

針對 Android 平台,Google 也整合了 Play for On-device AI(PODAI)服務。開發者只需利用 LiteRT 將 AI 模型與必要的 Runtime 函式庫打包成 AI Pack,當使用者從 Google Play 下載應用程式時,系統會自動分析裝置規格並派送相容的模型與運作環境,簡化了部署流程。

支援 Gemma 等先進生成式AI模型

此次合作的另一大亮點是對 Google Gemma 模型家族的全面支援。在聯發科的天璣 9500(Dimensity 9500)晶片發表會上,雙方展示了多款經過最佳化的模型,包括 Gemma 3 270M、Gemma 3 1B 以及專為行動裝置設計的多模態模型 Gemma 3n E2B。

資料顯示這些經過最佳化的模型在聯發科 NPU 上的執行速度比 CPU 快上 12 倍,比 GPU 快上 10 倍。以 Vivo X300 Pro 實測為例,Gemma 3n E2B 模型在處理 4K 上下文時,預填充速度超過每秒 1600 tokens,解碼速度則達到每秒 28 tokens,這樣的成績讓即時語音翻譯、視覺理解等複雜的多模態應用成為可能。

提升開發效率

為了讓開發者能更輕鬆地建構高效能機器學習管道,LiteRT 引入了簡化的 C++ API。這套新介面支援原生硬體緩衝區互通性(Native Hardware Buffer Interoperability),允許資料從 AHardwareBuffer 直接傳遞至 NPU,過程中無需進行資料複製,對於需要處理高吞吐量即時影像的相機與影片應用來說至關重要,能夠有效降低延遲並提升整體系統效能。

這次 Google 與聯發科的合作,可說進一步降低裝置端 AI 的開發時間,預期這個生態系的未來將有更多不錯 AI 應用出現在行動裝置上。

首圖由 Nano Banana AI 生成