NVIDIA 前陣子發表了號稱「全球最小 AI 超級電腦」的 DGX Spark,日前各家合作夥伴持續延後交貨進度,從九月一路延後到10月底到11月,也引發市場關注。畢竟,這款僅手掌大小的設備(150 x 150 x 50.5 mm),搭載全新的 Grace Blackwell 超級晶片,擁有 128GB 統一記憶體的設計,讓開發者能在本地端完成較大 AI 模型的訓練與推論,不必再仰賴較昂貴的 H200 / H100 之類的高視訊記憶體 AI 伺服器,或者是支付不少雲端 AI 算力服務的費用。

剛好最近海外媒體也有實際測試數字和感想,本文將帶你深入了解 DGX Spark 的硬體設計、效能表現、軟體整合,以及它如何重新定義個人級 AI 運算的可能性。

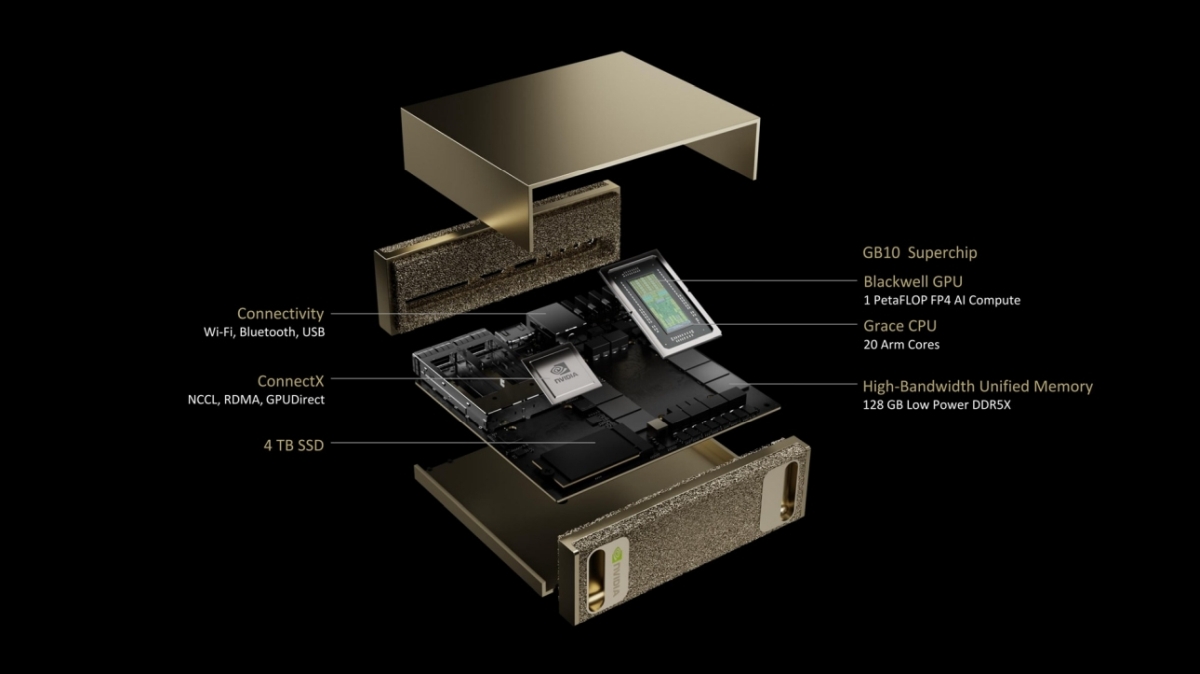

硬體規格與設計

NVIDIA DGX Spark 讓我們得以一窺個人 AI 運算的未來樣貌,它將過往專屬於 AI 資料中心的特性,比方說大容量記憶體、高頻寬乙太網路互連,以及 Blackwell 等級的效能,透過精煉並濃縮到一個製作精美且小巧的桌上型規格裝置中。

DGX Spark 的外觀設計極具質感,採用全金屬機身與香檳金的塗層,前後面板皆由金屬打造,令人聯想到 NVIDIA DGX A100 與 H100 的設計語彙。在連接埠方面,DGX Spark 提供了豐富的選項,包括四個 USB-C 埠(其中一個支援最高 240W 的電力傳輸)、一個 HDMI 埠、一個 10 GbE RJ-45 乙太網路埠,以及兩個由 NVIDIA ConnectX-7 NIC 驅動的 QSFP 埠,最高可提供 200 Gbps 的傳輸速率。值得一提的是,透過這兩個 QSFP 埠,使用者可以將兩台 DGX Spark 連接在一起,就擁有總計 256GB 的統一記憶體規模,能執行更大規模參數的 AI 模型。

在核心硬體方面,DGX Spark 搭載了 NVIDIA Grace Blackwell GB10 超級晶片,這是該公司和台灣大廠聯發科合作的產品,其 GPU 部分可提供高達 1 PFLOP 的稀疏 FP4 張量運算效能,AI 運算能力約介於 RTX 5070 與 5070 Ti 之間。最引人注目的特色是其高達 128 GB 的統一記憶體(coherent unified system memory),由 CPU 與 GPU 共享,是本地端執行大型 AI 模型的最重要基礎。

這個規格,讓全球開發者得以執行參數量高達 200B (2,000億) 的大型 AI 模型,或者使用內建的 ConnectX-7 高速網路介面卡將二台DGX Spark 系統串聯,執行參數量高達 405B 的 AI 模型推論任務。

效能評測與應用場景

另外,根據 LMSYS Org 的實測,DGX Spark 確實能夠載入並執行像是 GPT-OSS 120B 和 Llama 3.1 70B 這樣的大型模型,但這些工作負載較適合用於原型設計和實驗,而非正式的生產環境,因為它本身的速度沒有那麼快能擔任正式生產環境的角色。DGX Spark 的真正優勢在於處理中小型模型,特別是在採用批次處理(batching)以最大化吞吐量的應用場景下,表現尤其出色。

具體來說,在 Ollama 中執行我們報導過的 OpenAI GPT-OSS 20B(MXFP4)時,在 Ollama 中執行 GPT-OSS 20B (MXFP4) 模型時,Spark 的預填(prefill)速度為 2,053 tps,解碼(decode)速度為 49.7 tps;相較之下,RTX Pro 6000 Blackwell 則達到了 10,108 tps / 215 tps,速度快了約 4 倍。即使是 GeForce RTX 5090 也繳出了 8,519 tps / 205 tps 的成績,這證實了 Spark 的統一式 LPDDR5x 記憶體頻寬是主要的效能瓶頸,也就是說雖然記憶體比一般能跑 AI 推論的 NVIDIA 消費級顯示卡的 16GB、24GB、32GB 都來得大,但受限於於記憶體頻寬是比較便宜的規格版本,因此沒辦法有很好的 AI 運算成績。

不過,如果我們看它的測試資料,在處理較小的模型時,特別是 Llama 3.1 8B,DGX Spark 的表現反而則毫不遜色。在 SGLang 中以批次大小(batch)為 1 執行時,它達到了 7,991 tps 的預填速度和 20.5 tps 的解碼速度;當批次大小擴展至 32 時,效能也線性提升至 7,949 tps / 368 tps,這部分的效果則是不錯的。

從另一個角度來看,如千問 Qwen、 Llama 3.1 70B、Gemma 3 27B,甚至是 GPT-OSS 120B,這些大小的模型都能夠直接載入 DGX Spark 的記憶體,無需傳統上從系統記憶體傳輸到 VRAM 的處理和時間。在相關測試中,DGX Spark 成功以 803 tps 的預填速度和 2.7 tps 的解碼速度執行了 Llama 3.1 70B (FP8) 模型,對於一台能安靜放置在桌面上的小型工作站而言,這樣的表現已經算不錯了,是適合給開發者用的小型 AI 工作站,這種設計讓它在 AI 模型的原型開發、模型實驗和邊緣 AI 研究等領域是有價值的,畢竟,在這些應用場景中,夠大夠用的統一記憶體存取,會比原始的 TFLOPs AI 算力更為實用。

軟體生態系與開發者體驗,搭配 QNAP NAS 將相得益彰

CyberQ 也有幸接觸到該系統,看到的是 NVIDIA 以 Debian 為基礎的客製化 Linux 系統,DGX Spark 預先內建完整的 NVIDIA AI 軟體環境,整合了 GPU、CPU、網路、CUDA 函式庫以及 NVIDIA AI Enterprise 平台,讓開發者開機後即可投入 AI 相關程式與模型的開發工作。

由於這款產品能支援 NVIDIA 完整的 AI 生態系,相較以往架構較複雜或成本較高昂的環境,現階段使用者更容易在本地端建立與測試各類 AI 應用,例如微調德國的 FLUX.1 模型或中國的千問模型以最佳化圖像生成,運用 NVIDIA Cosmos Reason 視覺語言模型打造智慧搜尋與摘要代理,或基於 Qwen3 建構專為 DGX Spark 最佳化的 AI 聊天機器人。

開發者需要大量的資料存放時,就會需要至少 10 Gb 規格的高速網路交換器,搭配具備 10 GbE 網路連接埠的企業儲存設備、 NAS等等,QNAP 目前就有很多 NAS 是提供 10 GbE 的產品。如果你的 10Gb 交換器是全光口的,那就會需要搭配電轉光的光模組來使用,會比較熱,如果搭配光纖光模組、或 DAC 直聯線,溫度就會比較低。

NVIDIA DGX Spark 的高速 SSD 是 4TB 的版本,但如果要把模型資料和產出的檔案另外存放,會建議透過前面提到的網路交換器,用 10Gb 的速度和 NAS 做交換與存放,會比較實用。若購買是 NVIDIA 其他合作夥伴推出較平價的 1TB SSD 版本,NAS 的空間更適合一起搭配使用才夠力。

市場定位與價格

NVIDIA DGX Spark 的目標客群為 AI 開發者與研究人員,旨在提供一個高效能的本地端 AI 開發平台。DGX Spark 定價為3,999美元(約新台幣 123,032 元),於 10 月 15 日起在 NVIDIA 平台開放預訂,台灣地區的售價應該會略高,除了 NVIDIA 官方發售的 DGX Spark ,台廠四大品牌 華碩、宏碁、技嘉、微星也已發表各自採用 NVIDIA GB10 超級晶片的首款個人迷你 AI 電腦產品,也預計將於 10 月底到11月發貨,如果是 1TB SSD 規格的,價格約莫在 9 萬 7 千元到 11 萬元以內。

CyberQ 認為,NVIDIA DGX Spark 的問世,無疑為 AI 開發領域帶來了新的可能性,它並非為了取代雲端規模的基礎設施,而是為了將 AI 實作的開發門檻降低,直接帶到我們開發者的桌上。更重要的是它比較省電,在額定最大功耗 240 瓦的電力消耗下,它不僅將千萬億次級的 AI 運算能力帶到了個人電腦層級的環境,更透過完整的軟硬體整合,大幅降低了業界和學校進行 AI 開發的門檻。

DGX Spark 的USB-C 電源輸入(最高 240 W)和外部電源供應器,可以省掉如果裝在這台小電腦時額外的熱,所以和 Mac Mini 或 Mac Studio 相比,它們會出現過熱降速的問題,但Spark 不會,反而更適合長時間運作的工作站任務。

雖然在大型模型的生產環境中,DGX Spark 仍有其極限,它在原始吞吐量方面無法與全尺寸的 DGX 伺服器或獨立的 RTX GPU 匹敵,但其亮點在於易用性、高效率與多功能性。但在原型設計、實驗、以及中小型模型的應用上,DGX Spark 無疑是一款極具吸引力的產品,將為全球 AI 開發者帶來前所未有的便利性與可執行模型的夠大記憶體。

從執行 SGLang 和 Ollama 進行本地模型推理服務,到實驗推測解碼,再到透過雙 Spark 叢集探索分散式推理,這個平台證明了它不僅僅是一台微型超級電腦,更是為下一個 AI 時代而生的開發者沙盒。

首圖及配圖由 Goole Gemini AI 生成