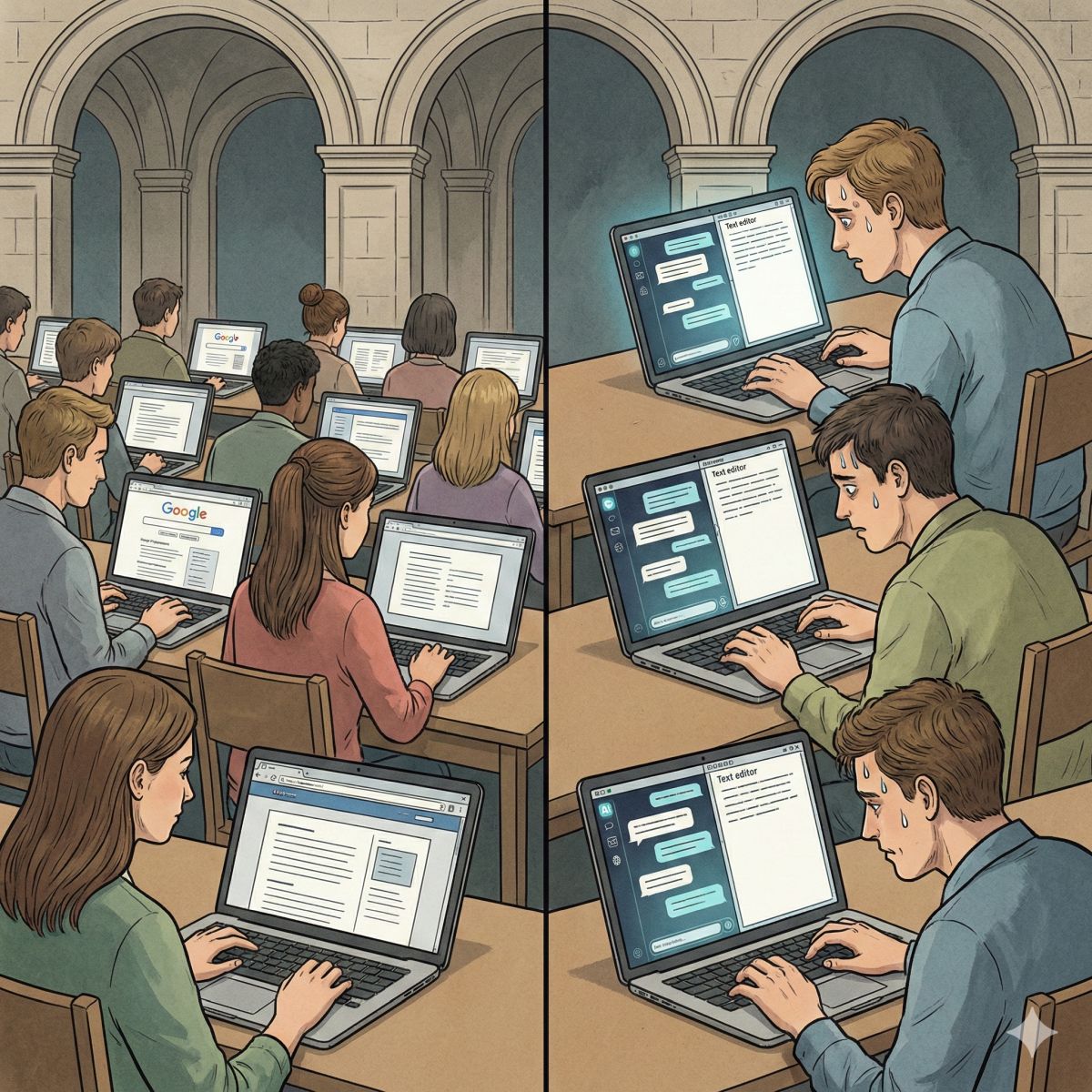

比利時魯汶大學(UCLouvain) 教授 Ploum 近期發表了一篇名為〈Giving University Exams in the Age of Chatbots〉的文章,詳述他在「開源策略」期末考中推動的一項實驗,開放學生在規定限制下使用 AI 聊天機器人作答。

這項測試出現的結果令人訝異,在60名學生中,只有 3 名學生選擇在考試中使用聊天機器人。Ploum 並非禁止學生使用 AI,而是將選擇權交還給學生,並制定了一套強調當責性的規則,意即學生必須對最終產出的結果負起完全責任,不能將錯誤推給 AI 工具。

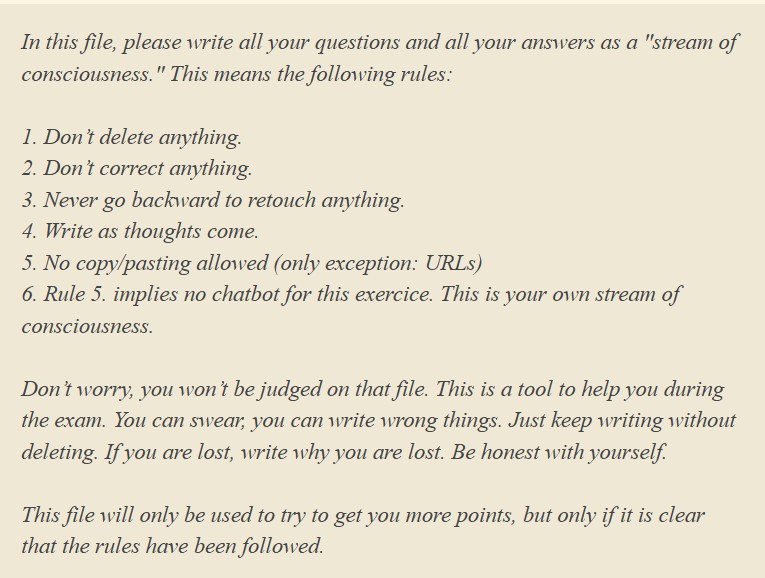

強制不准刪除思考歷程

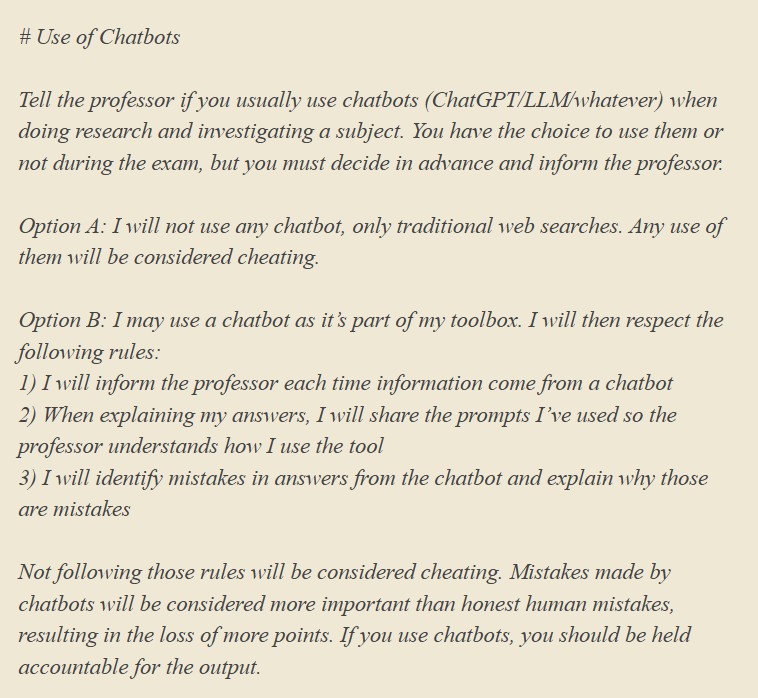

Ploum 教授在考前設計了兩種考試模式供學生選擇。選項 A 是傳統模式,學生僅能使用傳統的網路搜尋引擎,嚴禁使用任何聊天機器人,違者視同作弊。選項 B 則允許使用 AI 聊天機器人作為幫手,但必須公開提示詞並標註 AI 來源。

Photo Credit by Giving University Exams in the Age of Chatbots

然而,讓大多數學生打退堂鼓的關鍵,在於考試必須在不間斷思考歷程的方式下作答,教授的目的是捕捉學生當下最真實的思緒,所以規範了禁止刪除與回頭、禁止複製貼上等規定,在這些規範下,即使學生選擇可以使用 AI 的 B 選項,也不能將 AI 的答案直接複製貼上,必須消化內容後再自行將答案填入,不但無法節省時間,還必須在無法回頭修改內容的情況下即時作答,大幅增加了考試難度與心理壓力。

Photo Credit by Giving University Exams in the Age of Chatbots

當責性評分機制

除了輸入答案時的限制,Ploum 教授還規定,若學生選擇使用 AI,必須遵守三項規範:

1、誠實標註:資料來源為聊天機器人時,必須明確標註。

2、公開提示詞:在解釋答案時,必須分享所使用的提示詞,讓教授理解學生的使用邏輯。

3、除錯與分析:學生必須主動指出聊天機器人回答中的錯誤,並解釋AI回答錯誤的原因。

如果學生直接引用了聊天機器人的錯誤資訊而未察覺,將比一般自行作答所產生的錯誤承擔更高的扣分,使用 AI 的學生必須對產出的內容負起完全的責任。

僅有5%學生使用AI協助考試

實驗結果顯示,儘管 AI 功能強大,絕大多數學生為了避免因當責機制被扣更多分,仍選擇保守的作答方式。最終全班 60 名學生中,僅有 3 位選擇使用 AI 協助作答。

這項測試也反映出,如果使用 AI 需要經過繁瑣的驗證、除錯並承擔更高風險時,學生寧願相信自己的判斷與傳統的搜尋方式。對於尚未具備足夠專業知識能精準判斷 AI 幻覺的學生來說,直接使用 AI 來輔助考試反而增加了答題的心理負擔與時間成本。

考試巧妙地模擬了真實職場的情境

根據 Hacker News 社群的相關討論串,有網友指出,專業人士使用 ChatGPT 與學生用來考試、寫作業是截然不同的兩件事。專業工作者通常已經具備辨識錯誤的能力,使用 AI 是作為提升效率的輔助工具。而學生正處於學習階段,過度依賴 AI 可能會剝奪他們建立基礎知識的機會。

也有觀點認為,這個考試巧妙地模擬了真實職場的情境。在職場上,使用工具是被允許的,但員工必須對自己產出的結果負責。若員工直接複製貼上 AI 生成的錯誤程式碼或資料,而不做任何驗證,其後果將不堪設想。透過這樣的考試機制,實際上也是在訓練學生如何正確、負責任地與 AI 協作,而不只是單純的防弊。

這項實驗的結果值得教育界深思,與其全面防堵,不如透過設計巧妙的規則,引導學生理解 AI 工具的侷限,以及 AI 使用者應承擔的責任。

首圖由 Nano Banana AI 生成