在這個 2.5GbE 逐漸成為主機板標配的時代,對於追求極致傳輸效能的玩家、影音創作者以及擁有高效能 NAS(如 QNAP)的用戶來說,10GbE(萬兆網路) 才是真正優先要部署的網路環境。

可以參考 CyberQ 這篇 只要幾千元 ! 打造便宜且穩定的 10GbE 網速環境,實作家庭與辦公網路升級 的實戰文章來建構。

然而,跨入 10GbE 的門檻不僅僅是買一張網卡這麼簡單。市面上的介面規格(RJ45 vs. SFP+)、線材種類(DAC、光纖、CAT6a)以及容易混淆的術語(GBIC),常讓新手在採購時踩坑。

本文以實務上採購的經驗協助大家避開地雷,精準去買你需要的東西,並教你如何用業界標準工具 iPerf3 測試驗證你網路環境中的網速頻寬。

硬體採購指南,介面與規格之戰

要升級 10GbE,第一件事就是決定你的「介面」。這決定了你後續所有的採購方向。

1、網路卡(NIC)選擇:電口(RJ45)還是光口(SFP+)?

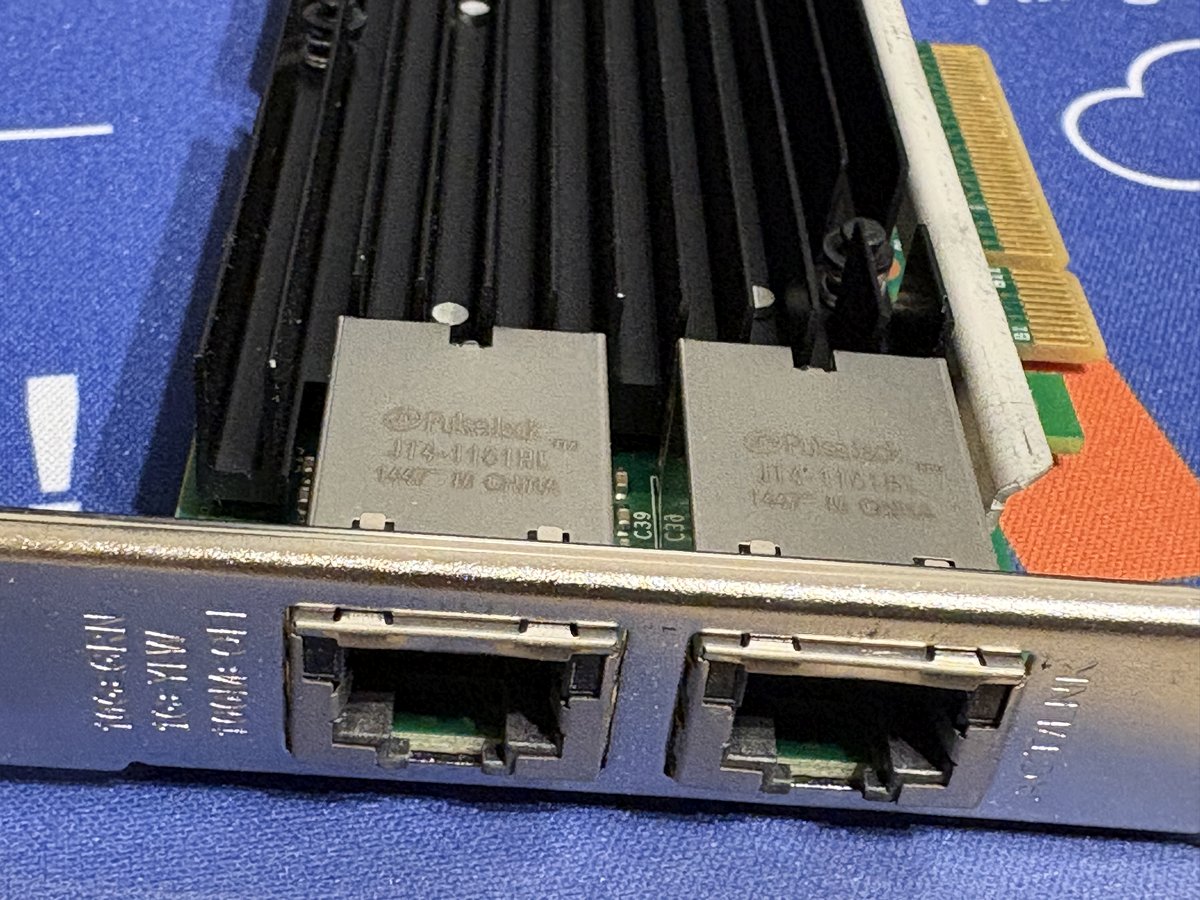

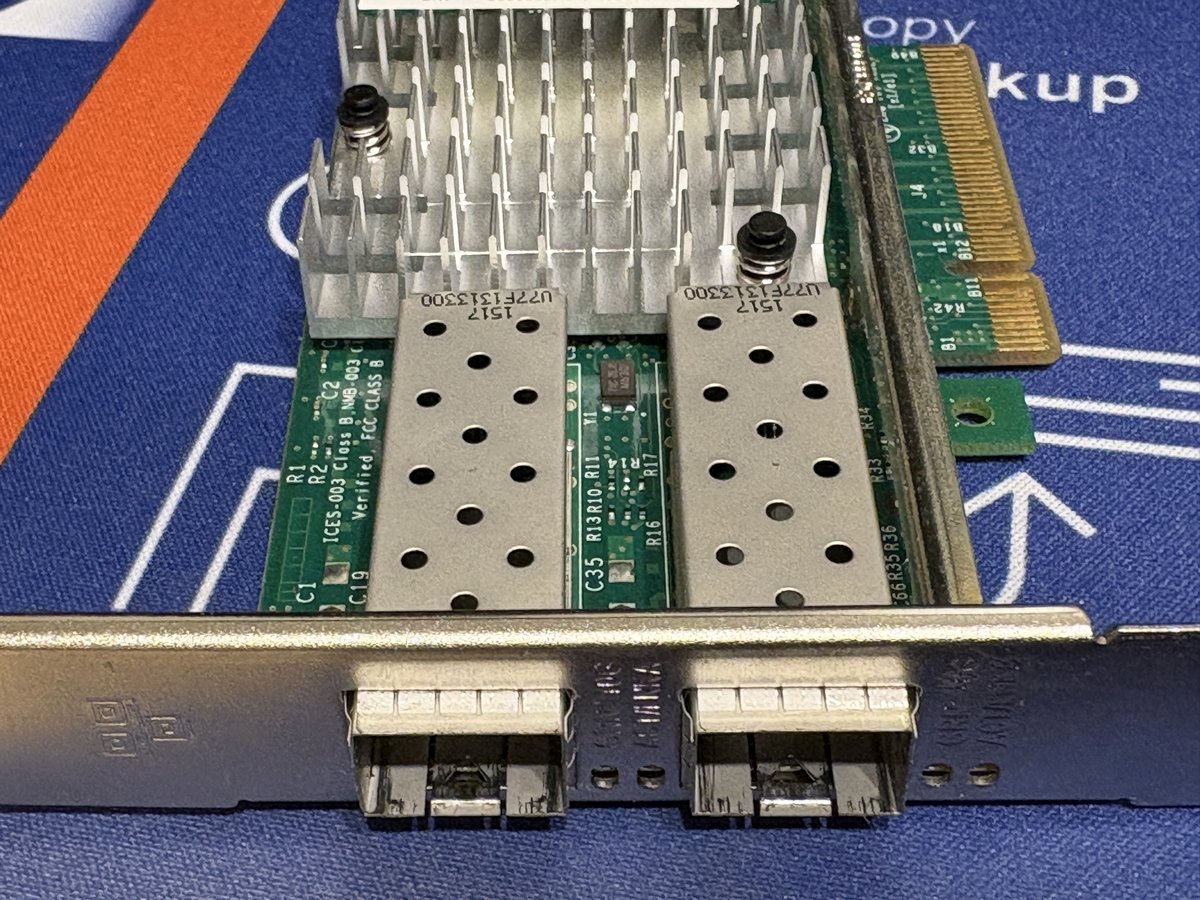

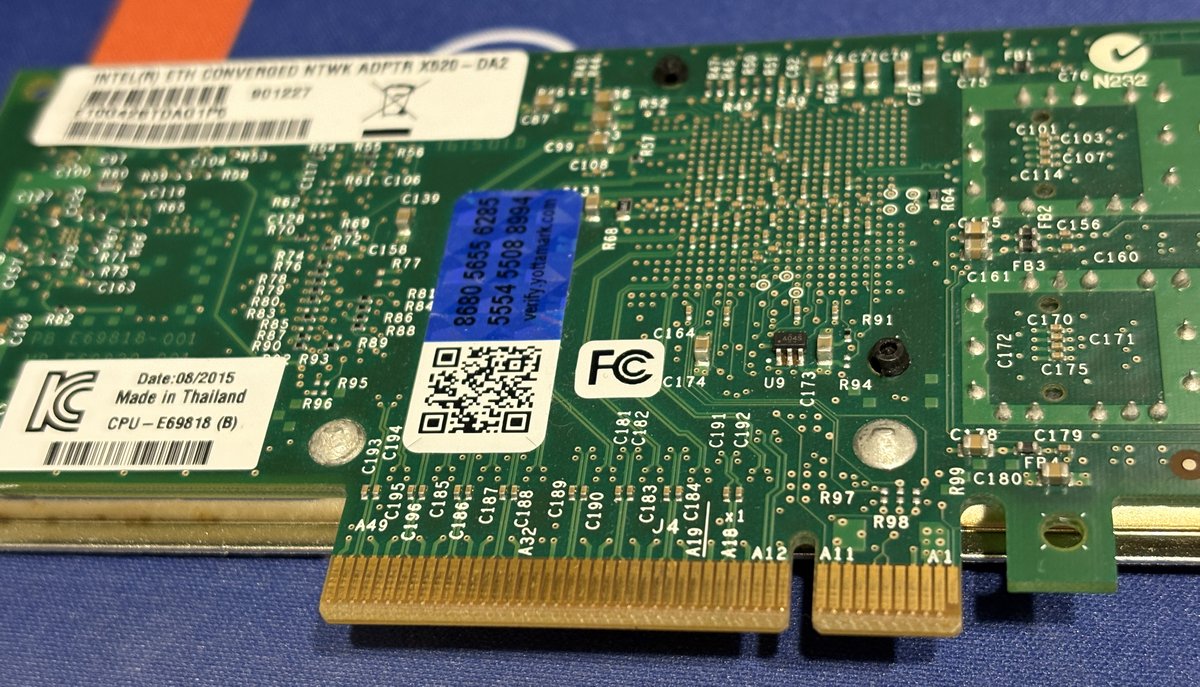

這是最多人糾結的點,以下是 CyberQ 在機房環境中常用到的兩種 Intel 晶片的 10GbE 網路卡為例,一個是RJ45(10GBASE-T)規格的 HPE 561T (Intel X540 T2),一張則是SFP+(10GBASE-S)規格的 Intel X520-DA2,補充一下,這種型號產品後面的後綴數字 2 是代表有 2 個連接埠的意思。

然後如果要買新網路卡的話,採用台灣瑞昱半導體 Realtek 價廉物美的 10 GbE 網路晶片 Realtek RTL8127 的網路卡已經大量出現在市場上了,價格差不多 1500 元新台幣上下,相當實惠,也是好選擇,你可以選 PCI-e 4.0 的單電口卡、PCI-e 3.0 的單電口卡,或 SFP+ 單光口卡,再來搭配你要採購的 10GbE 網路交換器。

PCIe 3.0 x4 和 PCIe 4.0 x1 的差別在於頻寬速度和通道數,PCIe 4.0 x1 速度快兩倍,每通道約 2GB/s,PCIe 3.0 x4 通道數多,共 4個通道,對於網路卡而言,如果你的網路速度超過 1G/2.5G ,如我們本例使用的 10G 網路,PCIe 4.0 x1 速度的效能會更好,但如果只是 1G/2.5G 網路,兩者都能輕鬆應付,x4 提供的多通道有助提升穩定性,但 4.0 速度優勢通常更關鍵。

RJ45(10GBASE-T)網路卡:

優點: 沿用傳統網路線,親切感高,與現有設備相容性好(可降速跑 2.5G/1G)。

缺點: 比較熱,且耗電量較高,延遲略高於光纖。

CyberQ 建議,如果你家中已經佈好了 CAT6 以上的暗管線路無法抽換,這是唯一解。晶片建議選購 Aquantia 系列(常見於 ASUS、QNAP 網卡)或 Intel X540/X550(注意散熱)。

SFP+(光纖/DAC)網路卡:

優點: 延遲極低、功耗低、發熱量低。這也是企業級伺服器的主流標準。

缺點: 需要額外購買模組或特定線材。

CyberQ 建議,如果是設備與設備之間(例如 PC 對接 NAS,或 PC 連接 Switch),SFP+ 絕對是首選。二手市場上有大量的伺服器拆機卡(如 Intel X520-DA2, Mellanox ConnectX-3/4),CP 值極高。

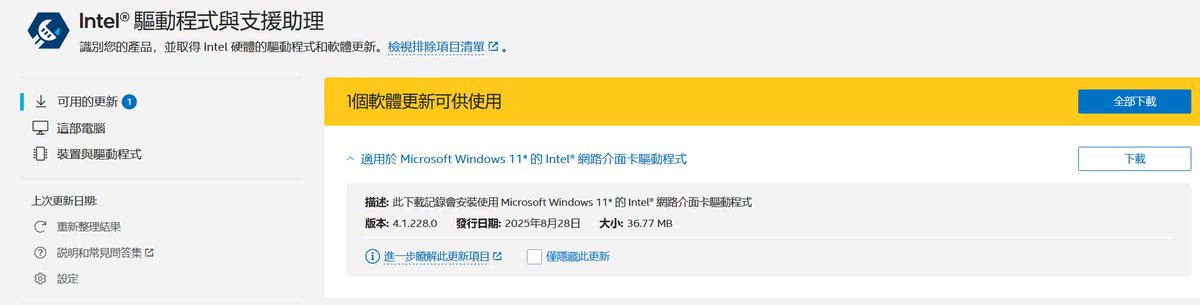

這種二手卡或新卡裝機好後,安裝 Windows 11 驅動程式是很方便的事情。

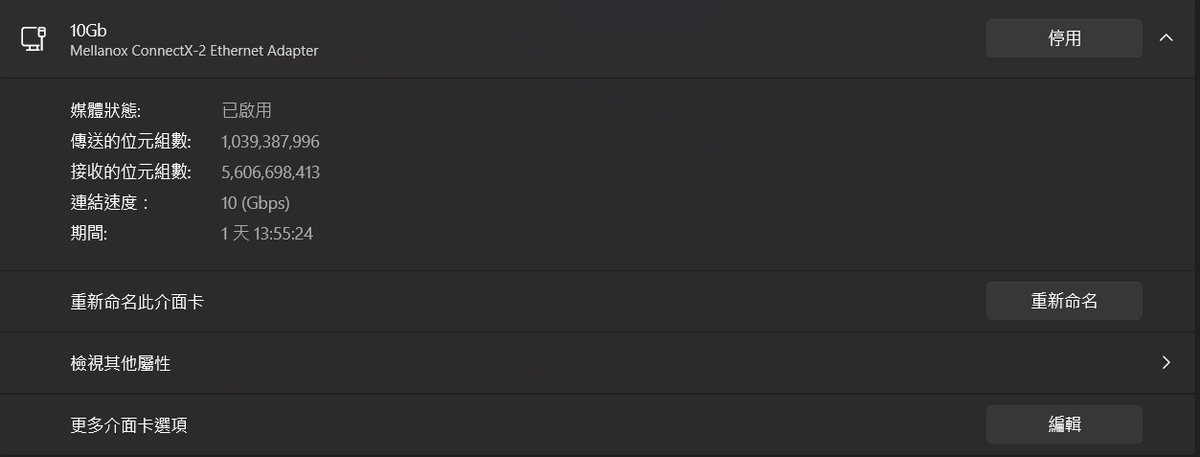

上圖中是 CyberQ 另一台電腦採用的則是舊卡,Mellanox ConnectX-2 10GbE SFP+ 網路卡,以色列 Mellanox (邁倫科技) 可是大有來頭,它是網通領域中極具歷史地位的品牌,早在被 NVIDIA 以6 9 億美元收購 Mellanox 之前,就已在高效能運算(HPC)與資料中心市場建立起深厚基礎,並長期主導 InfiniBand 與高速 Ethernet 技術發展。 2019 年 NVIDIA 宣布收購 Mellanox,並於 2020 年完成交易,將其高速網路技術正式納入 NVIDIA 的資料中心版圖。在此之後,Mellanox 的 200 GbE、400 GbE 等高階網路卡與交換器產品,成為 NVIDIA AI 與 HPC 叢集架構中不可或缺的一環,並以 NVIDIA Networking 品牌持續推進。

CyberQ 實測和使用中的 NVIDIA DGX SPARK 機器上的高速網路連接埠 ConnectX-7 也是 Mellanox 技術在 NVIDIA 生態系中實作更上一層樓的新一代產品。從上圖中可以看到右邊有兩個 ConnectX-7 連接埠可上 200 GbE,中間有一個 10G 網路連接埠,是採用瑞昱半導體 Realtek 的晶片。

2、搞懂 SFP+、GBIC 與 Transceiver(光收發模組)

很多讀者習慣講「買 GBIC」,但其實 GBIC 是十幾年前的舊規格(體積較大)。現在我們在 10GbE 看到的介面標準名稱是 SFP+ (Enhanced Small Form-factor Pluggable)。

當你選擇了 SFP+ 介面的網卡或 Switch 後,你需要填滿那個插槽,有兩種選擇:

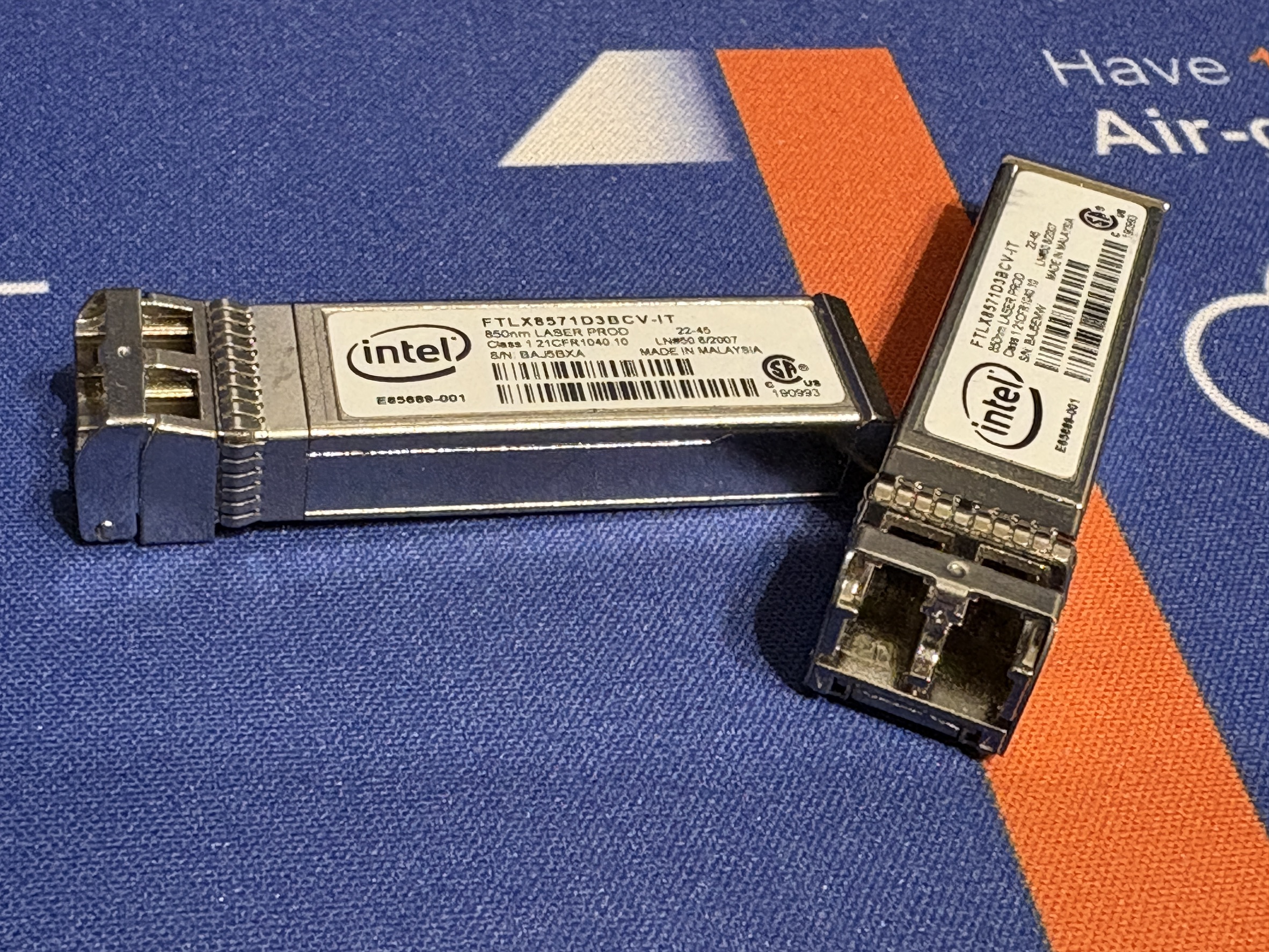

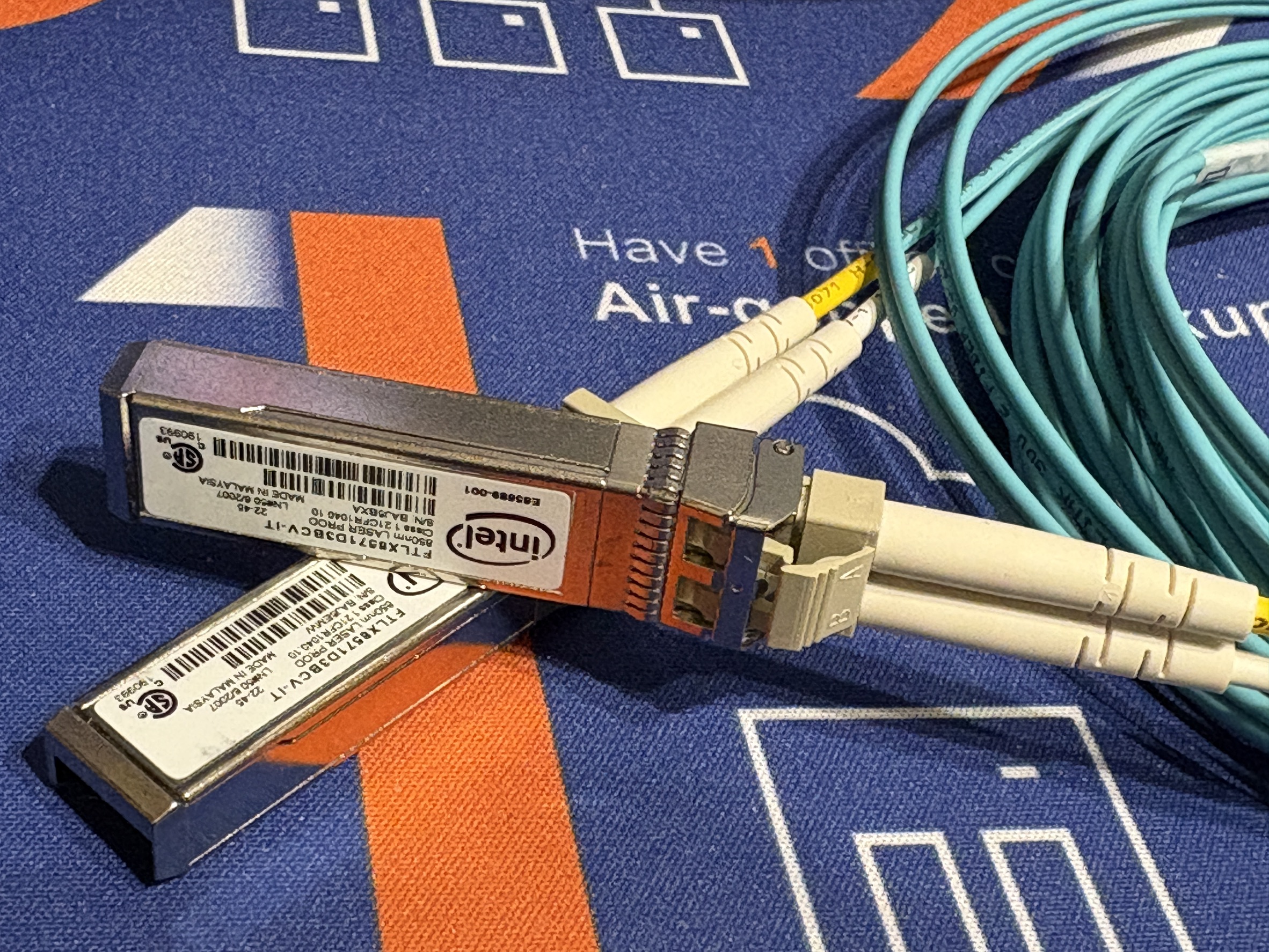

A. 光收發模組(Optical Transceiver)+ 光纖線

如果你需要長距離傳輸(超過 10 公尺),或者需要電氣隔離(抗雷擊、抗干擾),請選這個。

規格關鍵字:

SR (Short Range),搭配多模光纖(Multimode Fiber, MMF),常見波長為 850 nm。 傳輸距離依標準不同,約 100~300 公尺(部分新規格可達 400 m)。 模組與光纖成本低,設備取得容易,非常適合 機房內、家用、工作室、企業內部佈線。要注意的是,300 公尺是 10G + OM3 的典型值,不是所有 SR 都能跑到 300 m。

LR (Long Range)LR,搭配單模光纖(Single-mode Fiber, SMF),常見波長為 1310 nm。 傳輸距離通常為 10 公里以上(依規格可到 20 / 40 km)。 模組與施工成本較高,在一般家用或工作室環境通常沒有必要。

這邊要另外說明的是,LR在一般辦公室與家用環境沒必要的真正原因並不是距離,而是這樣的環境較少超過 100 m 室內拉單模纖維,單模光纖的纖芯細(9µm),施工與接頭品質要求高,模組價格也比較高。

如果採用上面我們提到的 SR + OM3 / OM4,容錯高,插上光纖轉換器就跑,二手市場超多,尤其是 10G SR,價位都很便宜。

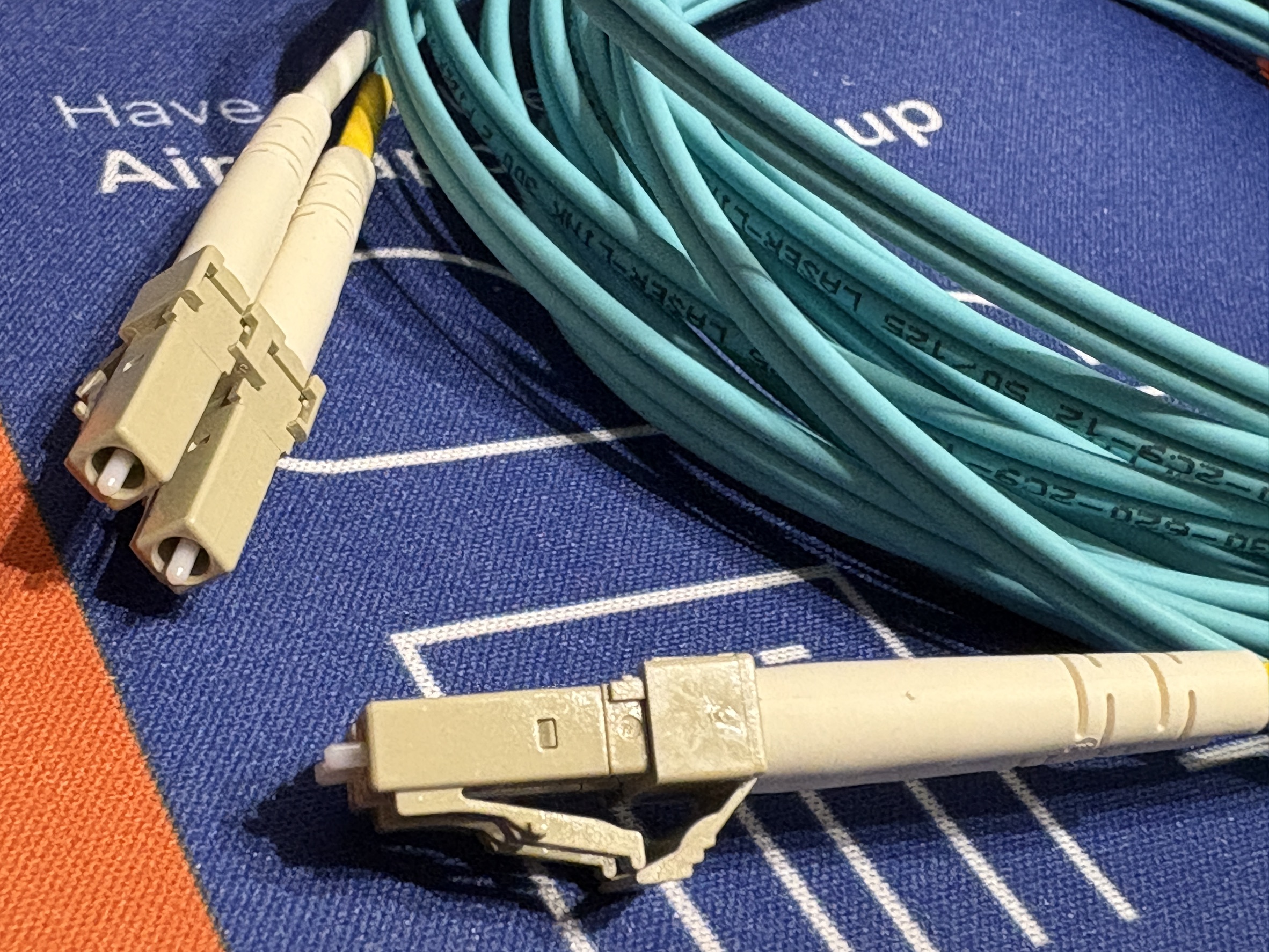

上圖為 SR OM3 LC-LC 多模雙芯光纖線。

線材搭配: 記得買 OM3 或 OM4 等級的 LC-LC 接頭光纖線(通常是水藍色或紫羅蘭色)。

B. DAC 直連纜線(Direct Attach Copper)必推薦神器

如果你的 NAS 就在 Switch 旁邊,或者 PC 距離 Switch 不到 3 公尺,請直接買 DAC!

DAC是什麼 ? 這是把兩端的 SFP+ 模組和中間的銅軸線做死在一起的一條線。

優點: 便宜(比買兩個光模組+一條光纖便宜很多)、低功耗、幾乎零延遲、隨插即用。

採購重點分為被動式(Passive)與主動式(Active)。一般 3 公尺內買被動式即可,超過 5 公尺以上我們就建議改用更上面段落提到的光纖了,因為長距離 DAC 線身很粗且硬,不好整線。

3、線材總結表

| 需求場景 | 介面選擇 | 線材規格 | 備註 |

| 機櫃內短距離 (<3m) | SFP+ | DAC (Passive) | 最穩定、最便宜、最省電的方案。 |

| 跨房間/長距離 | SFP+ | 光收發模組 (SR) + OM3/OM4 光纖 | 光纖線細軟好走線,不受電磁干擾。 |

| 既有裝潢/沿用舊線 | RJ45 | CAT6 、CAT6a或 CAT7 | CAT6 在 10G 環境下距離有限制 (實際約 55m或更短),有較長空間需求才建議直上 CAT6a。 |

軟體實測使用 iPerf3 驗收效能

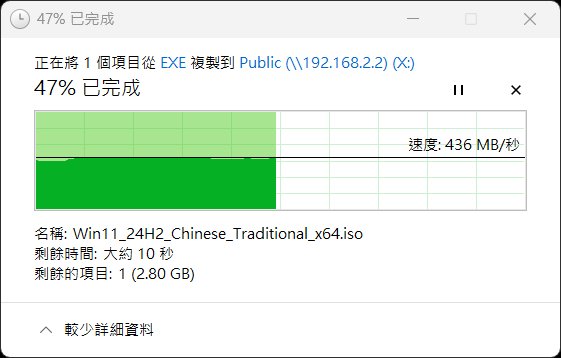

買了好用的新 10GbE 網路設備、網路卡與線材,怎麼知道有沒有跑滿 10Gbps?看 Windows 檔案複製速度是不準的,因為那會受限於硬碟(HDD/SSD)的讀寫速度(Disk I/O)。

我們要測試的是「純網路頻寬」,這時候業界標準工具 iPerf3 就派上用場了。

1、安裝 iPerf3

Windows: 下載解壓縮後,在該資料夾開啟 CMD 或 PowerShell。

Linux/NAS (Docker): 使用 apt install iperf3 或直接跑 Docker image。以 QNAP NAS 來說,直接部署 iperf3 的 docker image 即可。

也就是說,你要兩台設備測試之間的連線速度有沒有到 10GbE 環境,兩台都要有 iperf3 的軟體或容器部署才能跑喔。

Docker 的 iperf3 容器可以選這個版本 : https://hub.docker.com/r/networkstatic/iperf3

你會需要下的 docker 部署與執行指令如下,可以另外編寫 yaml 上傳執行,或在 Poratiner、QNAP 容器工作站中部署。

docker run -it –rm -p 5201:5201 networkstatic/iperf3 –help

docker run -it –rm –name=iperf3-server -p 5201:5201 networkstatic/iperf3 -s

2、測試架構

你需要兩台機器:

Server 端(接收端): 例如你的 NAS 或一台長時間開著的 PC。

Client 端(發送端): 你的工作桌機。

3、開始測試

Step 1: 啟動 Server 端 在 NAS 或 Server 上輸入:

Bash

iperf3 -s

這時畫面會顯示 Server listening on 5201,代表正在等待連線。

Step 2: 啟動 Client 端進行基本測試 在你的 PC 上輸入(假設 Server IP 為 192.168.1.100):

iperf3 -c 192.168.1.100

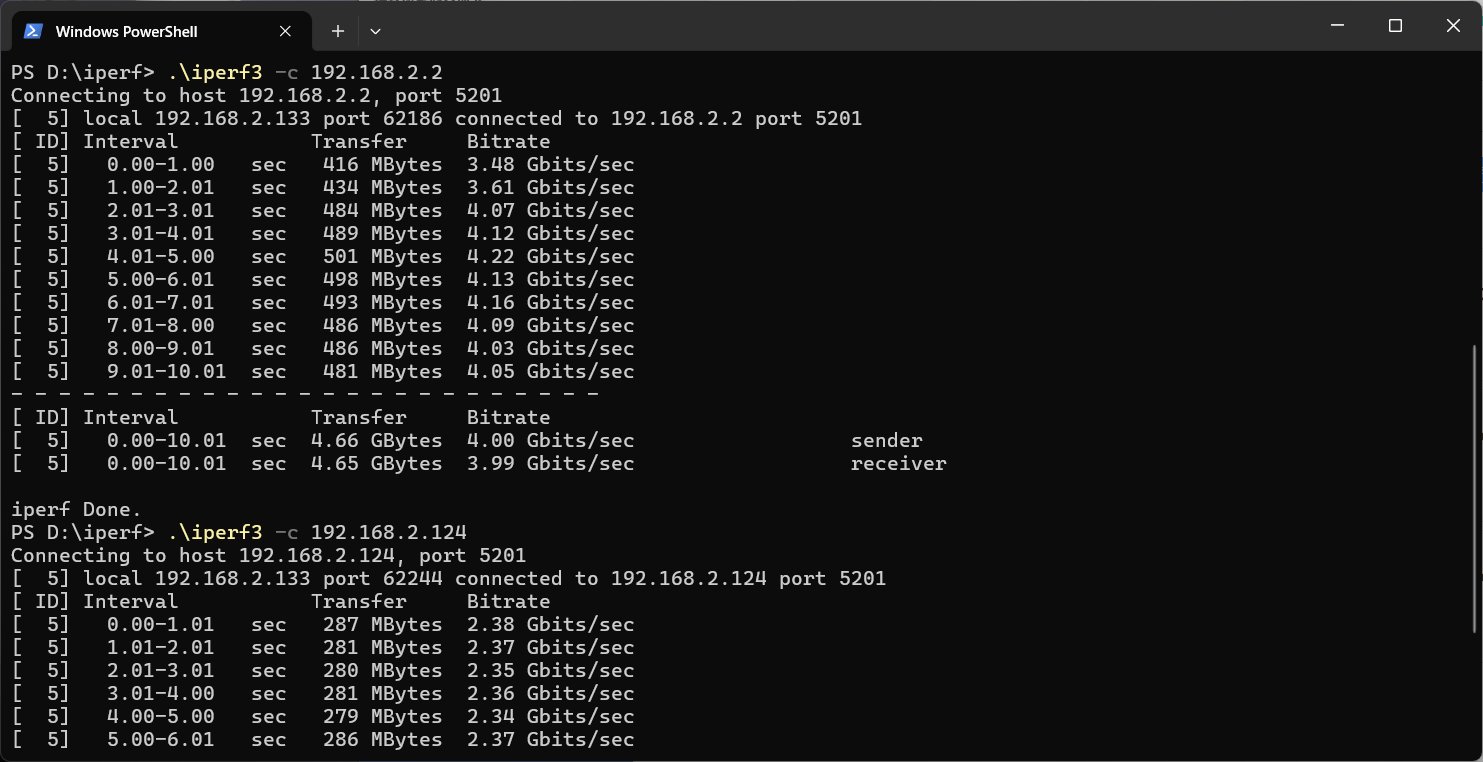

4、進階技巧:如何跑滿 10GbE?

很多新手第一次測,發現只有 3Gbps 或 5Gbps,就以為硬體壞了。其實是因為單一執行緒(Single Thread)受到 CPU 或 TCP Window Size 的限制,很難塞滿 10G 水管。

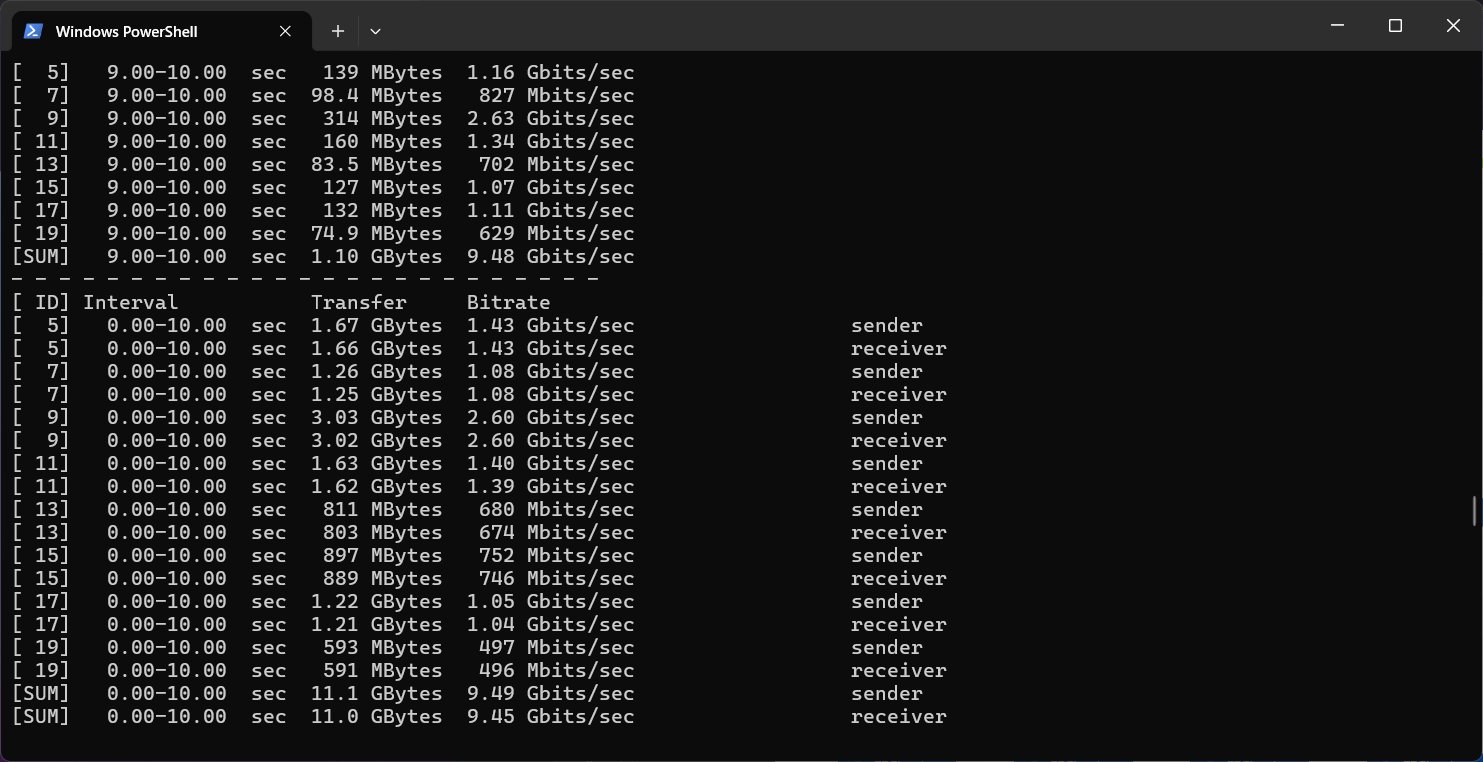

必殺技:開啟多執行緒並行(Parallel) 請在 Client 端加入 -P 參數,讓它同時跑 5 到 10 條串流:

Bash

iperf3 -c 192.168.1.100 -P 8

解析結果: 觀察最後的 SUM 行。

9.40 Gbits/sec 以上: 恭喜!你的網路環境非常完美(扣除 Protocol Overhead,這是極限值)。

5~8 Gbits/sec: 檢查是否開啟了 Jumbo Frames(巨型封包),或檢查線材品質。

1 Gbits/sec 以下: 你可能接錯孔,或者線材只有 CAT5e,導致協商速度掉回 1G。

5、關於 Jumbo Frames (MTU 9000)

在 10GbE 環境下,建議將網卡、Switch、NAS 的 MTU 值都設定為 9000(預設是 1500)。這能大幅降低 CPU 的負載並提升傳輸效率。但請注意,鏈路上的每一個設備都要支援並開啟,否則會造成封包破碎(Fragmentation)反而掉速。

升級 10GbE 是一條「回不去」的路。當你親眼看到 NAS 檔案傳輸速度突破 700MB/s-800MB/s(這已經超過普通SATA SSD 的極速),那種流暢度會大幅改變你的工作流。

CyberQ 建議:

能用 DAC 就用 DAC,省錢又穩。

能用二手企業級網卡(Mellanox/Intel)就別買貴鬆鬆的消費級新卡。

測試務必用 -P 參數,不要被單執行緒的輸出資料嚇到了。

希望這篇指南能幫助大家順利建構自己的高速區網。