AWS 在 2025 年的 re:Invent 大會上發布了多項涵蓋運算硬體、AI 模型與儲存服務的重大更新。歷經前一代 AI 晶片產品後,AWS 這次將硬體焦點集中在最新一代 AI 晶片 Trainium3 及其搭配的 UltraServer 伺服器,同時也針對軟體定義的 AI 代理人(AI Agents)與資料儲存架構進行了調整更新,自然是想辦法要在 AI 算力中心各家積極布局競爭的時局,鞏固 AWS 在雲端基礎設施的領先地位。

CyberQ 推薦看一下 AWS 這次活動的 Keynote 演講影片。

首款 3 奈米製程 AI 晶片 Trainium3 問世

Trainium3 是 AWS 首款採用 3 奈米製程技術打造的 AI 晶片。相較於前一代 Trainium2,新晶片在架構設計上有顯著突破。我們可以將其優勢區分為兩個不同層面來看:

大幅降低研發成本:在 AI 模型的「訓練」階段,重點在於算力的總量與耗電量。Trainium3 提供了高達 4.4 倍的運算效能提升,同時在能源效率上也增加了 4 倍。對於需要長時間運算的大型公司而言,這代表能用更短的時間、更少的電力完成模型開發,直接解決了最昂貴的研發成本問題。

最佳化即時互動體驗:當模型實際上線並開始服務使用者時,AI 「推論」的反應速度與服務量能成為關鍵指標。根據測試資料顯示,Trainium3 相較於前一代的回應延遲(Latency)已大幅縮減,速度快了 4 倍;同時單一晶片的吞吐量(Throughput)也提升了 3 倍。換言之,使用者能更快速地獲得 AI 回覆,而採用的公司,也能在同一時間內能服務更多的客戶。

UltraServer 伺服器整合144顆晶片

為了充分發揮 Trainium3 的效能,AWS 同步推出了全新的 Trainium3 UltraServer 伺服器。這款伺服器採用高度整合的垂直設計,單一系統內最多可封裝 144 顆 Trainium3 晶片。這種高密度的配置,旨在解決分散式 AI 運算中常見的通訊瓶頸。

UltraServer 配備了新一代的 NeuronSwitch-v1,網路傳輸的頻寬是前一代的兩倍。透過強化的 Neuron Fabric 網路技術,晶片之間的通訊延遲被壓低至 10 微秒以內。這對於需要大量資料交換的集合專家模型(MoE)或代理人系統(Agentic AI)來說,是至關重要的硬體優勢。

擴大與NVIDIA合作並推出混合雲方案

儘管 AWS 大力推動自研 AI 晶片,但其策略仍保持多元開放。大會中也同步發表了搭載 NVIDIA GB300 NVL72 架構的 P6e-GB300 UltraServer,這是目前 EC2 上配備最高 GPU 記憶體與算力的執行個體,專為兆級參數模型的即時推論所設計。

此外,針對有資料落地需求的客戶,AWS 推出了「AWS AI Factories」,允許企業在自有的資料中心內,部署包含 NVIDIA GPU 或 Trainium 晶片的 AWS 專用 AI 基礎設施,兼顧了雲端技術的便利性與地端部署的合規性,這樣一來雲地結合的要素會比以往更齊備。

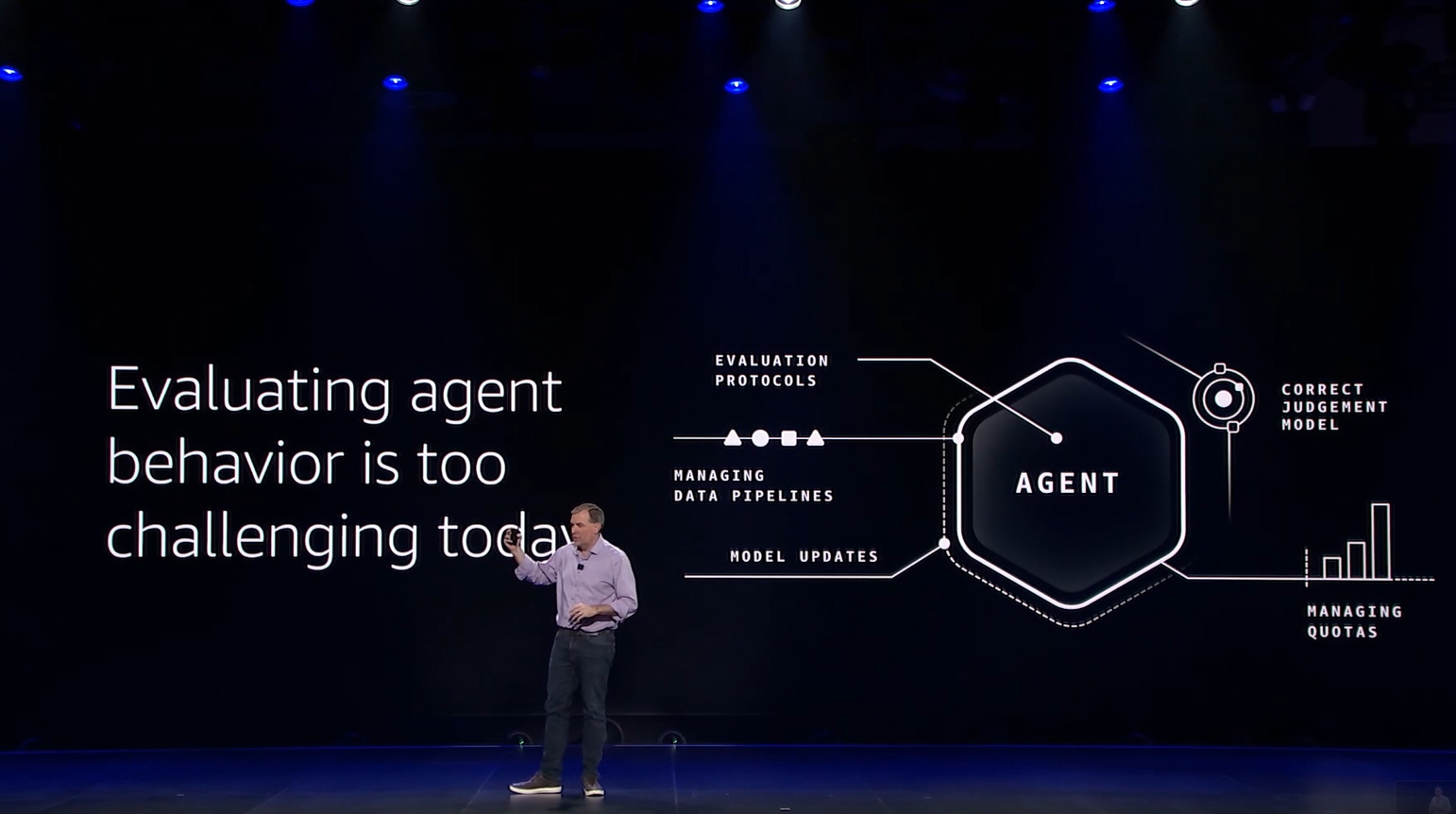

AI 模型與 Frontier Agents 代理人新紀元

在軟體與模型層面,AWS 宣布擴充 Amazon Nova 模型家族,並推出了「Nova Forge」功能,完全客製化結合企業自有資料與 Nova 的預訓練模型。更引人注目的是全新推出的「Frontier Agents」,這是一類能自主運作數天且無需人工干預的 AI 代理人。

首波發布的三款代理人包括:

Kiro Autonomous Agent:扮演虛擬開發者角色。

AWS Security Agent:擔任資安顧問。

AWS DevOps Agent:負責維運操作。

這些 AI 代理人能與新發布的 Amazon Bedrock AgentCore 搭配使用,協助開發者管理 AI 的行為邊界與記憶功能。另外,AWS Transform 服務也加入了 Agentic AI 能力,號稱能加速舊有程式碼現代化的速度達 5 倍之多。

儲存與開發工具的關鍵更新

為了支撐龐大的 AI 資料處理需求,AWS 也對儲存服務進行了多項最佳化。新發布的 Amazon S3 Vectors 讓使用者能直接在 S3 物件儲存並查詢向量資料,單一索引支援高達 20 億個向量,大幅簡化 RAG 應用開發。S3 的單一物件大小上限從 5TB 提升至 50TB,能夠容納高解析度影片或巨型訓練資料集。S3 Batch Operations 的處理速度也提升了 10 倍。

至於在開發工具方面,AWS Lambda 推出了 Durable Functions,這是一項允許函式在執行過程中暫停並保存狀態長達一年的功能,非常適合處理付款流程或是需要更長週期的 AI 工作流。在資安方面,GuardDuty 的威脅偵測範圍也進一步擴大至 EC2 與 ECS 環境。

預告 Trainium4 晶片將支援 NVLink Fusion 技術

在發表 Trainium3 的同時,AWS 也提前預告了下一代晶片 Trainium4 的開發藍圖。Trainium4 預計將在效能上帶來更顯著的提升,目標是提供比 Trainium3 高出 6 倍的 FP4 處理效能,以及 3 倍的 FP8 效能。

值得注意的是,AWS 透露 Trainium4 將設計支援 NVIDIA 的 NVLink Fusion 高速互連技術。這項策略性的技術整合,將使得 Trainium4、Graviton 處理器以及 EFA 網路卡能在通用的 MGX 機架架構下無縫協作,為未來的 AI 資料中心提供更具彈性的混合算力選擇。

建構全方位的AI運算生態系

CyberQ 觀察,AWS 在 2025 年的佈局展現了其在 AI 基礎設施領域的野心。從底層的 Trainium3 自研晶片與 UltraServer 算力堆疊,到上層的 Frontier Agents 應用開發,以及支撐這一切的 S3 資料儲存架構,AWS 正透過軟硬體整合來降低 AI 開發的門檻。

AWS 新發布的 AI 代理三傑,Kiro Autonomous Agent、AWS Security Agent、AWS DevOps Agent,對市場的影響很值得留意。

我們如果看 AWS 執行長 Matt Garman 在開幕主題演講中說的:「Agentic AI 將成為企業真正釋放AI價值的關鍵,未來貢獻佔比將達80%至90%。」未來這方面的發展很值得繼續關注與投資,各家在這部份的競逐,會有技術力和實作能力的顯著差異,競爭態勢自然就能分得出來,對於 AI 應用開發者和廠商而言,這是個快速變動的時代,技術選型和生態系的導入是否正確或跟得上,都考驗業者和開發者們的智慧。

面對激烈的市場競爭,AWS 既強化自有硬體的成本優勢,也保持對NVIDIA 生態系的開放支援。隨著 AI 應用逐漸從單純的模型訓練轉向更複雜的自主代理人系統,這些基礎設施的升級將成為未來幾年推動技術創新的關鍵動力。

首圖 Google Gemini AI 生成