在人工智慧(AI)領域,開發者與研究人員普遍面臨一個挑戰,也就是即使我們給予完全相同的提詞(Prompt),大型語言模型(LLM) 在不同時間點也可能生成相異的結果。這種現象不僅妨礙了科學研究的再現性,也對需要高度穩定性的應用場景構成阻礙。

過往,LLM 的「不確定性」(Nondeterminism)學界普遍將此問題歸咎於「平行運算與浮點數的結合假說」(Concurrency + Floating Point Hypothesis)。該假說的核心在於,多 GPU 環境下的「平行運算」與電腦的「浮點數運算」這兩個特性結合後產生的放大效應。

在語言模型反覆無常的回答背後,科學家解密了令人意外的決定性因素,推翻過去對 AI 隨機性的常識。

首先,電腦在處理小數(即浮點數)時天生存在著微小的精確度限制,這導致了運算的「非結合性」,也就是(a + b) + c ≠ a + (b + c)。其次,在平行運算中,任務被分配給成千上萬個核心同時處理,但我們無法預測哪個核心會先完成。

AI 是否真的在擲骰子?究竟是怎麼回事 ?

雖說在量子力學領域,上帝真的會擲骰子,但 AI 呢? 若簡單地解釋,這就好像一個有千名廚師的巨型廚房,每位廚師都負責一部分的食材,你無法保證每一次,都是負責番茄的A廚師,比負責馬鈴薯的B廚師,早0.01秒把食材丟進鍋裡。雖然他們都完成了任務,但食材被加入湯中的「順序」,每一次都可能有些微的、不可預測的隨機變化。這就是「平行運算」帶來的隨機性。

當這兩個因素結合,運算順序的隨機性,觸發了浮點數的非結合性。最終,即使配方與食材完全相同,每次烹煮出的湯品風味(運算結果),都可能產生微乎其微的差異。

然而,由前 OpenAI 技術長 Mira Murati 所創立的 AI 研究機構「Thinking Machines Lab」近期發表了首篇研究文章《Defeating Nondeterminism in LLM Inference》,徹底顛覆了這個傳統觀點。

不確定性的真正元兇:批次大小(Batch Size)的變異

Thinking Machines Lab 的研究團隊指出,儘管浮點數運算問題確實存在,但它並非 LLM 推理不確定性的主要原因。他們透過實驗與分析發現,問題的核心在於「批次處理的非不變性」(Lack of Batch Invariance)

在實際應用中,LLM 推理伺服器(如vLLM)會根據當下的系統負載,動態調整傳入模型的批次大小,例如,在流量高峰期,伺服器可能會將多個使用者的請求合併成一個大批次進行處理;而在離峰時段,則可能以較小的批次運作。這就好像伺服器是個電梯系統,而 AI 是位住在100層樓的大師,大家都想搭電梯上去問大師問題,離峰時段時,電梯一次只載一個人 ( 這就是小批次,Batch Size = 1 ),尖峰時段時,為了效率就會盡量把電梯塞滿人再出發 (以這個案例來說就是大批次,Batch Size = 8),研究人員發現,現行許多核心的運算(Kernels),其計算結果會受到批次大小的影響。

就好像當電梯一次只載一個人時,都能夠很順暢地快速直達 101 層樓,當電梯一次載8個人時,因為重量和平衡的關係,電梯會產生微小的晃動,走的路線甚至有點偏移。換言之,一個批次大小為 8 的運算結果,與 8 個批次大小為 1 的運算結果,在數值上會存在細微差異。正是這種因伺服器負載而隨機變動的批次大小,構成了 LLM 輸出不確定性的主要來源。

實現「批次不變性」:邁向可再現的 AI

為了驗證此論點並解決問題,Thinking Machines Lab 開發了一套「批次不變性」的核心運算函式庫,包含對 RMSNorm、矩陣乘法(Matmul)及注意力機制(Attention)等關鍵操作的修改。

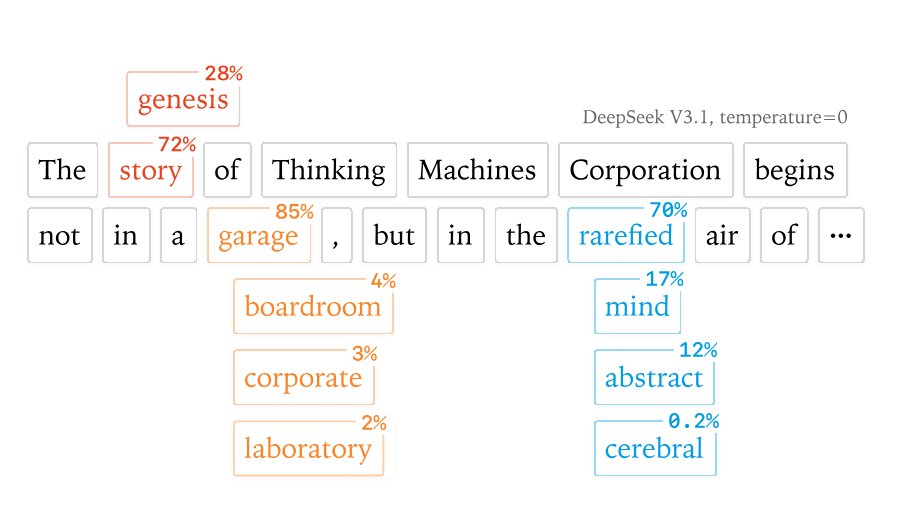

團隊以目前業界流行的中國通義千問 Qwen3-8B AI 模型進行測試,實驗結果驚人,他們在標準設定下,將溫度係數(Temperature)設為 0,並對同一提示重複執行 1,000次,竟產生了 80 種不同的輸出。然而,在換上他們開發的「批次不變性」核心後,1,000 次的執行結果完全一致。

(Figure Credit: Thinking Machines Lab,在 DeepSeek 3.1 溫度係數設定為 0的 情形。 )

這項成果證實了,只要能確保運算過程不受批次大小變化的干擾,LLM 的推理過程就能實現完全的確定性與可再現性。當然,這項創舉也伴隨著代價。目前,實現「批次不變性」的運算核心,其執行速度較標準版本慢。不過,研究團隊已透過對注意力機制的最佳化,成功縮小了效能差距。

Thinking Machines Lab 認為,對於追求科學嚴謹性、模型安全性驗證以及程式除錯等領域而言,犧牲部分效能以換取結果的完全可再現性,是絕對值得的。他們也期望,這項研究能啟發未來AI推理引擎的設計方向,讓「確定性」成為與「速度」同等重要的考量指標。

這篇開創性的研究,不僅為解決 LLM 長久以來的隨機性問題提供了清晰的路徑,也為 AI 領域的科學化與工程化奠定了更穩固的基礎。

首圖由 本地端 LLM 生成,配圖為 Google Gemini AI 生成