當 NVMe 已經快過你的區域網路環境,100GbE 網路的導入是必然的,在這幾年我們看著 SSD 從 SATA 進化到 NVMe Gen4 與 Gen5,動輒 7,000 MB/s 甚至 10,000 MB/s 的讀寫速度,傳統 10/25GbE 網路常成為資料高速傳輸的瓶頸,因此 100GbE 在特定應用(如全快閃 NAS 與大型虛擬化環境)中越來越受重視。

當你的全快閃(All-Flash)NAS 內部傳輸快如閃電,卻在網路端被 10GbE 甚至 25GbE 卡住時,升級 100GbE 已經不再是遙不可及,而是為了解放效能並應加速進行的解決方案。

在討論「100GbE 進入戰國時代」之前,一個常見的誤解是,400GbE / 800GbE 在高速資料中心與 AI 市場受矚目後,是否代表 100GbE 即將被淘汰?

實際情況恰好相反,100GbE 目前的角色,類似當年的 10GbE 與 25GbE,在成本、成熟度與實務彈性已經取得最佳平衡,簡單說就是市場甜蜜點已到,價格夠便宜就可以買了。

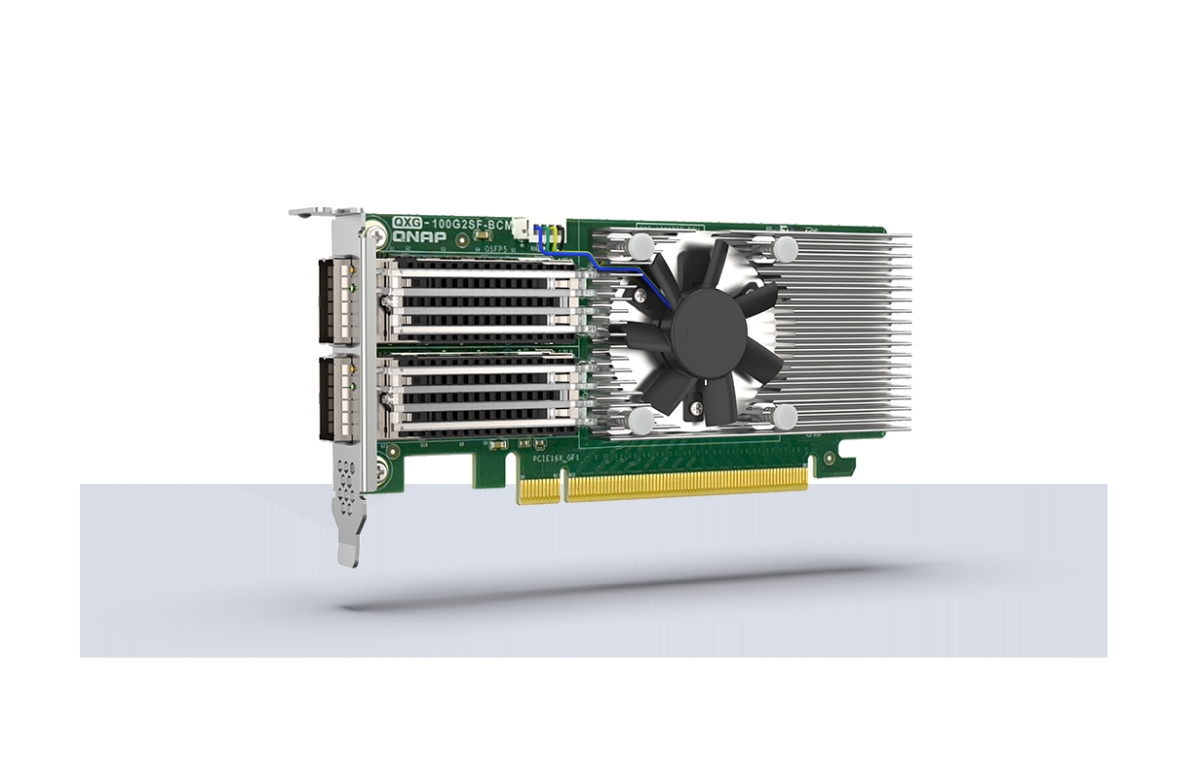

最近,QNAP 發表推出了採用 Broadcom 晶片的全新 100GbE 網卡 QXG-100G2SF-BCM,這在原本以 NVIDIA (Mellanox) 和英特爾晶片為主流的高階網卡市場中是更省電和合理成本和效能組合的新選擇。今天我們就藉由這張新卡,來聊聊現在 100GbE 的市場生態、二手網拍樂趣,以及企業建置的一點眉角。

QNAP QXG-100G2SF-BCM 新卡解析

QNAP 這張新卡的核心採用了 Broadcom NetXtreme-E BCM57508 控制器。對於熟悉伺服器市場的朋友來說,Broadcom 的 NetXtreme E 系列一直以高穩定性與優異的 CPU 降載能力著稱。這款晶片打造的網路卡陸續變多,符合 OCP3.0 規範,適用於資料中心、雲端伺服器、AI 訓練等多種高頻寬需求場景。

重點規格一覽:

晶片: Broadcom BCM57508

介面: PCIe Gen 4.0 x16(這是關鍵,確保雙埠跑滿 200Gbps 的頻寬需求)

連接埠: 雙 QSFP28

關鍵技術: 支援 SR-IOV(單根 I/O 虛擬化)、RoCE v2(RDMA over Converged Ethernet)。

這張卡的推出,意味著 QNAP 在高階網卡供應鏈上除了 NVIDIA 和 Intel 外,增加提供給偏好 Broadcom 生態系的企業用戶另一個原廠支援的選擇。它的最大優勢在於能徹底釋放 NVMe 全快閃儲存的 IOPS,尤其是在高密度的虛擬化環境或 AI 訓練資料集傳輸中,能有效降低 CPU 的負載。

100GbE 網卡的「戰國時代」,二手 vs. 主流 vs. 新品

目前的 100GbE 網卡市場非常有趣,為了方便說明,我們簡單地將其分為四組,給適合不同預算與需求的企業用戶或 HomeLab 用戶:

「洋垃圾」的高 CP 值傳說 Mellanox ConnectX-4

如果你是 Homelab 玩家或預算有限的 IT 人員,Mellanox ConnectX-4 (CX4) 絕對是你聽過的名字。

市場行情: 目前網拍或二手市場價格極香,大約新台幣 2,800 元(去海外賣場找甚至更低)就能入手。

優點是價格極度親民,Linux 支援度極佳,是入門 100G 的首選。

缺點是較舊的製程,發熱量與功耗相對較高,且 PCIe 3.0 x16 在某些極限場景下可能略顯頻寬吃緊(相較於 PCIe 4.0),但對家用或中小企業來說效能已經過剩。

Mellanox ConnectX-4 是舊世代 100GbE 卡,對於 Homelab 與入門用途具成本效益。下方介紹的 ConnectX-6/6Dx 則為更高階設計,具更先進卸載能力與更豐富 RDMA 支援。

當今的 100GbE 中高階標準卡 NVIDIA (Mellanox) ConnectX-6 Dx

在 NVIDIA 收購以色列著名的 Mellanox 後,高速網路產品與 NVIDIA 用在 AI 環境的 DPU 新品輩出,而其推出的 ConnectX-6 Dx 成為了市場上的效能標竿。

參考產品: QNAP QXG-100G2SF-CX6。

它的定位是目前企業級的主流選擇,相比 CX4,CX6 Dx 在硬體 Offload、資安加密加速以及對 NVMe-oF 的支援上更為先進,延遲更低。如果你的環境是跑高頻交易或極端要求的 AI 運算,這通常是標準配備。

藍色巨人的穩健反擊:Intel Ethernet Controller E810

在伺服器領域,我們絕不能忽視 Intel 的存在感。QNAP 推出的 QXG-100G2SF-E810 正是搭載了這款有相當使用度的 Intel Ethernet Controller E810。

參考產品: QNAP QXG-100G2SF-E810。

規格重點是同樣採用 PCIe 4.0 介面,提供總頻寬高達 100Gbps 的傳輸能力。

定位方面,Intel E810 系列強調的是極致的相容性與應用程式隊列(ADQ)技術。對於那些企業 IT 架構已經深度綁定 Intel 伺服器生態系,或是極度重視驅動程式穩定度、不想花時間除錯的網管人員來說,E810 是一張穩健的選擇。

挑戰者登場:Broadcom BCM57508 (QNAP QXG-100G2SF-BCM)

這就是近期的另一個選項,畢竟 Broadcom 與 NVIDIA 在高階網卡市場各有千秋。

QNAP QXG-100G2SF-BCM 這款產品的優勢主要為 Broadcom BCM57508 同樣支援先進的 RoCE 與 SR-IOV。對於某些已經大量部署 Broadcom 交換器或特定伺服器架構的企業來說,選用同晶片廠商的網卡在相容性與除錯上可能會更順。且 PCIe 4.0 x16 的頻寬保證了雙埠全速運作不掉速。

該怎麼選呢 ?

| 特色比較 | 網拍神物 (Mellanox ConnectX-4) | NVIDIA (Mellanox) (QNAP QXG-100G2SF-CX6) | Intel (QNAP QXG-100G2SF-E810) | Broadcom (QNAP QXG-100G2SF-BCM) |

| 核心晶片 | Mellanox ConnectX-4 (舊款) | ConnectX-6 Dx | Intel® E810-CAM2 | Broadcom BCM57508 |

| 匯流排介面 | PCIe 3.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 4.0 x16 |

| 主要優勢 | 極致 CP 值 Linux 支援度極高,適合練功與中小企業、Home Lab 環境。 | 低延遲與 AI 加速 硬體 Offload 強大,支援 NVMe-oF 與加密加速,HPC 首選。 | 穩健相容性 x86 生態系相容性佳,驅動程式需留意確認,企業長期維運用。 | 高吞吐生態系 搭配 Broadcom 交換器整合性佳,SR-IOV 虛擬化效能優異。 |

| 潛在短板 | 製程較舊 發熱量較高,PCIe 3.0 頻寬在雙埠全速下較吃緊。 | 價格門檻 效能優異,但通常價格也是市場上較高價位。 | 中規中矩 功能均衡,但在極致的低延遲競賽中略遜於 Mellanox。 | 市場後進 在消費級/中小企業市場能見度剛起步,驅動需留意版本更新。 |

| 適合對象 | Homelab 玩家、IT 測試人員 (二手卡 NT$ 2,500~2,800或更低) | AI 訓練、高頻交易、金融業 (追求極致效能) | 傳統企業機房、關鍵單位 (追求穩定) | 大型資料中心、虛擬化叢集 (追求高密度部署) |

這四款網卡的排列組合,恰好解決了不同層次的需求:

預算先決 (Homelab/測試環境),秒選二手 ConnectX-4。

AI 運算/極低延遲 (HPC)),首選 NVIDIA ConnectX-6 Dx。

企業穩定/相容性優先 (Enterprise)),推薦 Intel E810。

高密度虛擬化/ Broadcom 生態系,考慮新款 Broadcom BCM57508。

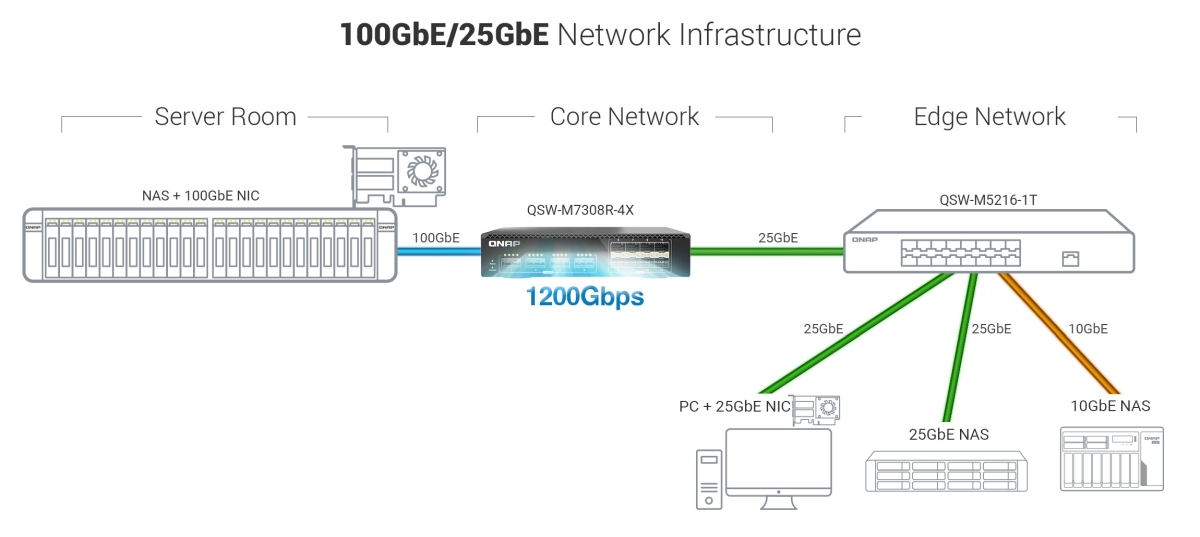

別忘了交換器與線材的「隱形成本」

想要享受 100Gbps 的快感,光買網卡是不夠的,這也是很多企業和個人用戶卡關的地方。

100GbE 交換器 (Switch) 會需要採購需要支援 QSFP28 介面的產品。以 QNAP 來說,他們自家有推出搭配的 QSW-M7308R-4X(支援 100GbE) 去搭配 QNAP 一系列高階 NAS 與前面提到的三種晶片 100 GbE 網路卡來使用,這類產品通常價格不菲,是建置成本中佔比最高的一環。

線材 (Cabling):

短距離 (機櫃內): 推薦使用 DAC (Direct Attach Cable) 銅纜。便宜、耐用、延遲最低,也不用擔心收發器過熱。

長距離 (跨機櫃/跨樓層): 必須使用光纖 (Fiber) 搭配光收發模組 (Transceiver)。這裡的水很深,單模、多模、MPO 接頭規格繁多,且光模組價格差異巨大。

為什麼 100G 需要 FEC?

最後,CyberQ 分享一個在部署 100GbE 環境時,90% 的人都會遇到的「坑」。

很多朋友買了 100GbE 新網卡,興沖沖地接上 Cisco、QNAP、MikroTik 或 Ubiquiti 的 100G 交換器,燈號亮了,但在系統裡卻始終顯示「Link Down」或是封包完全打不通。這時候請不要著急,問題通常出在 FEC(Forward Error Correction,前向錯誤更正) 的模式不相容。

和隨插即用的 1GbE/10GbE 不同,100GbE 的訊號頻率極高,在傳輸過程中更容易受到干擾。因此,在 100GbE 與更高速率連線中,IEEE 標準定義了 FEC 機制來確保資料完整性,FEC 是必須的來確保高速信號可靠傳輸,不同設備預設 FEC 模式不同會導致協商失敗,因此手動設定一致性是常見必要步驟。

但在真實世界中,不同的線材(DAC 銅纜 vs. 光纖)與不同的交換器晶片,預設的 FEC 模式可能不同。最常見的兩種模式為:

RS-FEC (Reed-Solomon, Clause 91): 這是目前 100GbE 最主流的標準,糾錯能力強,通常用於 SR4/LR4 光纖或長距離 DAC。

Base-R FEC (FireCode, Clause 74): 較舊或較輕量的標準(常預設於 25GbE),糾錯能力較弱,延遲較低。

鬼打牆的真相是自動協商失敗

理論上,網卡跟交換器應該要能「自動協商(Auto-Negotiation)」講好用哪一種 FEC。但現實是殘酷的,特別是當你混用 Broadcom(如這張 QNAP 新卡)、Mellanox 與 Intel 不同廠牌的設備時,自動協商有時候是會失敗的。

典型症狀會出現在交換器端預設跑 RS-FEC,但是網卡端(或舊款 DAC 線材)預設跑 Base-R 或 Off。結果會造成兩邊像是在講不同星球的語言,實體層(Layer 1)連線建立失敗。

如果你遇到連線問題,可依照這些步驟檢查,進入交換器 CLI 或管理介面,強制指定該 Port 的 FEC 模式。再來是統一標準,對於 100GbE,建議雙方都手動強制設定為 RS-FEC,是一種先求穩定的相容性最大公約數。

假設你有支援 100GbE 的 NAS,以 QNAP 來說也要檢查 QTS 設定,QNAP 的網路與虛擬交換器設定中,通常也允許針對高階網卡調整 FEC 模式。如果是跑 Linux (Proxmox/Ubuntu),則可以使用 ethtool –set-priv-flags 指令來調整。

誰需要 100GbE 或更高速的區域網路環境?

CyberQ 觀察,在企業資訊環境中,網路頻寬不能成為儲存設備的瓶頸。

如果你是全快閃 (All-Flash) NAS 用戶: 100GbE 是必須的。NVMe SSD 的 RAID 陣列隨便都能跑出 30GB/s 以上的內部頻寬,只有 100GbE (約 12.5GB/s) 才能勉強餵飽它的一部分效能。所以 NVIDIA 更高速的 400GbE 交換器是資料中心、AI 高階環境中常見的選項,可以突破 100GbE 既有的規格限制,他們也還有 800G 網路交換器的選項提供給市場。

如果你是虛擬化/備份管理者: SR-IOV 是虛擬化 I/O 的硬體虛擬化機制,可讓 VM 直接訪問物理網卡虛擬功能(VF),而 RoCE(RDMA over Converged Ethernet)是一種在以太網上實現 RDMA 傳輸的協議。兩者可以互補提升虛擬化與高效能網路傳輸效能,大幅降低 CPU 負載(CPU Offload),這對於備份關鍵任務或高密度 VM 環境非常重要。

而如果覺得 100 GbE 環境的建構成本還是很高,市場上的 25GbE 環境已經很成熟,另外,也可以參考 CyberQ 這篇 只要幾千元 ! 打造便宜且穩定的 10GbE 網速環境,實作家庭與辦公網路升級,直接先升級到 10GbE 環境,這已經是企業網路環境的低消。

以前我們覺得 10G 就很快了,但看著 ConnectX-4 只要兩千多塊的現在,再看看 QNAP 積極佈局 Broadcom 與 Intel 、NVIDIA 等產品線的 100G 新卡,100GbE 在更多企業網路環境中落地的比例提升,或許比我們想像中來得更快。

當前的 100GbE 市場可說因 AI、全快閃儲存與企業私有雲的成長,進入真正的普及成熟期。在可預見的未來,100GbE × 400GbE 的分工共存,將是區域網路世界的常態,而非例外。